高级辅助驾驶系统:驾驶员应知应会!

时间:10-23

来源:互联网

点击:

Ron Wilson,总编辑,Altera公司

接近黄昏的时候开始下雨了,驾驶员们纷纷打开大灯。很快,湿滑的路面反射了大灯灯光、街灯、商场霓虹灯,还有西沉的阳光,路面看起来像万花筒那样闪烁着各种光芒。自然光在减弱,而夜晚的灯光还不是那么明亮,路面看起来模模糊糊。

雨刮器很久没有工作了,您感觉前面就像涂了泥一样昏暗,路边的阴影也好像挡在了路中央。在朦胧中,您意识到车的盲点范围里有一辆没开大灯的车,您打着转向灯,摸索着向中间车道行驶。突然,您想起了自己的车里应该有先进的主动安全系统。

近期可能出现的三种结果

这个故事可能有三种不同的结果,技术取胜,人战胜机器,还有可能发生事故。可能是这样的:在您认识到将要发生什么之前,转向灯已经开始闪烁,自己的车稍稍向中间车道加速,然后,轻轻的刹车,避开了附近看不到的行人,也提醒了后面的车辆。

也可能是这样:当车轮转向时,您感觉到汽车的车道保持功能在起作用,把车拉回到原来的车道。但是,您仍然继续,打着转向灯,安全的并线,对其他车辆刺耳的喇叭声不闻不问。而此时,行人从路边冒出,前挡风玻璃前视显示系统没有让您及时看到这个人。好在您躲开了他。

或者,可能这样:您转向时,您听到了不熟悉但是非常刺耳的报警声。在您还没有搞明白怎么回事时,一辆车从盲点里鸣着喇叭冲出来—现在,您没有别的选择,只能慌乱的刹车停下来。防抱死刹车功能在湿滑的路面上起作用了,让您感到恐慌,车子终于紧挨着受惊吓的行人停下来了。在极度惊恐中,您瞥了一眼仪表盘,知道了疯狂报警的原因—高级辅助驾驶系统 (ADAS) 关闭了。

这就是同一个场景三种完全不同的结果。这源于三种完全不同的 ADAS 。为说明这些不同,理解其影响,我们将详细研究 ADAS 的实现。在今年的设计自动化大会上,举行了一次主题研讨和公开论坛,对此很好的进行了阐述。

从传感器开始

ADAS 系统是逻辑流水线,要理解它最好从宽输入范围入手。福特汽车电子和电气系统研究主任兼研究员 James Buczkowski 说:“随着向自动化方向的发展,难点在于仅采用一种传感器是远远不够的。”

在公开论坛上,主持人是 Cadence 总编辑 Brian Fuller ,他也要求专家们研讨一下 ADAS 传感器。传感器系统供应商 Nuvation 首席设计工程师 Edward Ayrapetian 认为,“目前我们使用了多种类型的传感器。一般而言,您会看到激光雷达、普通雷达和高分辨率视频摄像机的组合使用。但是随着图像处理算法的改进,所有一切都在不断变化。”

Ayrapetian 解释说,每一类传感器都有其优缺点,其他专家对此也表示同意。例如,激光雷达是谷歌 “无人驾驶” 汽车研究平台的主要传感器。这一技术的标志是激光器和旋转的镜子构成的半个圆球。激光雷达比较擅长勾勒出物体的外形,并提供距离数据—这些都是目标识别算法所必须的。而且,激光雷达对背景光线也不太敏感。

Ayrapetian 提醒说,“但是谷歌使用的激光雷达传感器价格高达 10 万美元。” 而且,在有雾或者下雪等低能见度的时候,从物体表面反射回来的光束所携带的信息量很少,激光雷达就不太好用了。Ayrapetian 提到了非常著名的加州沙漠聚会,“我们把自动驾驶卡车开向‘火人’。我们所知道的是,激光雷达无法识别一大片尘雾和砖墙。”

而雷达在一定程度上是非常好的互补技术。如果您仔细选好了频率、波形和接收信号处理功能,那么,雷达不会受到干扰的影响,实际上在低能见度和光照条件下都能正常工作。大陆汽车系统和技术公司 ADAS 业务部主任 Christian Schumacher 补充说:“雷达能够很好的获得距离数据。但是,雷达不擅长识别物体。” 不太理想的外形数据,而且没有纹理或者颜色信息,这让物体识别算法无法工作。

因此,我们使用了摄像机。随着低成本高分辨率摄像机的出现,视频成为 ADAS 的关键传感器技术,为物体识别提供了丰富的数据。多摄像机系统能够避开某些视觉障碍,提供虽然有限但是足够用的基于视差的距离信息。但是摄像机也有其问题,能见度差的时候无法工作。Schumacher 提醒说:“摄像机对光照要求很高。我们需要找到平衡点—一种在所有驾驶条件下都非常高效的系统,但是不能有太多的传感器。”

通过采用更好的算法来互相补充,以减少传感器。Ayrapetian 说:“我们要考虑传感器所面临的问题及其关键程度来定制传感器。如果把需求缩窄,就能够改进算法。我们基本能够采用更好的视频流图像处理算法来替代激光雷达。”

传感器融合

即使在图像处理技术上有所突破,大家一致认为仍然需要先进的传感器融合技术才能从几种不同类型的数据中,获得车辆周围环境正确的信息:物体,其速度和加速状态,以及可能的行为等。一个重要而且复杂的问题是,在系统中要进行多少次处理。有可能是将所有的原始数据送入融合引擎—例如,卡尔曼滤波器或者深度学习神经网络,看一看能够得出什么。这种想法有一定的可行性,例如实际上有一类特殊的网络,卷积网络,它用在物体识别时的性能非常好。

但是,设计人员更倾向于采用他们在操作层面上能够理解的系统。在5月份举行的嵌入式视觉大会的一次研讨中,谷歌自动驾驶汽车团队的技术主任 Nathaniel Fairfield 说:“我们的策略是开发简单的系统来处理传感器数据,然后,以更抽象的方式来融合经过预处理的数据。我们更愿意通过一个大滤波器来运行所有一切。”

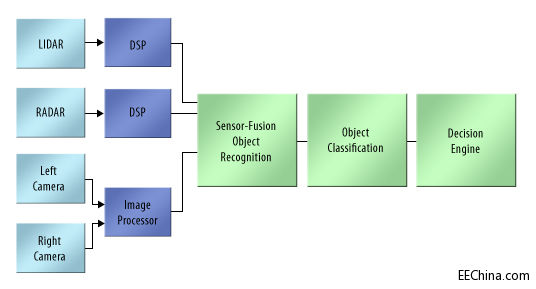

一种简化的方法是对处理步骤进行逻辑排序 (图1)。每一个传感器都会进行本地信号调理,甚至可能根据下游的反馈来自动适应。然后,每一个传感器会在本地根据其掌握的信息进行物体估算,为推断出的这些物体附加一些属性。

图1. 您可以把ADAS看成是处理器流水线,越来越抽象的看待汽车周围的环境。

例如,激光雷达能够确定地面 030 方向有一个物体,从右向左移动,距离大概 20.24 米。雷达也会报告,在同一位置,地面噪声背景上可能有一个物体。一对高分辨率摄像机会看清楚这一物体—看起来非常像一头金色猎犬,方向在 025 至 035 之间,大概 15 米之外。

这些信息会被传送至融合引擎,接收有物体存在这一主视图,附加上最可靠的属性—例如,位置、速度、大小和颜色。这些信息随后会被送至一个分类引擎,将其标示为一条狗—例如,位置、速度、大小和颜色。这些信息随后会被送至一个分类引擎,将其标示为一条狗

这看起来很有逻辑性,但却不能解决问题。甚至在每一阶段采用哪类算法都没有达成一致。Schumacher 观察到:“目前,大部分步骤都是基于规则的。但是,基于规则的系统需要很多支持。我们会看到一些算法采用了人们不好解释的方法。”

本田北美研究所的首席科学家 Victor Ng-Thow Hing 同意这一观点,“深度神经网络在识别任务上会远远超过人,甚至超过基于规则的算法。有些方面会否定规则。我认为应该有一种混合方法。”

Ayrapetian 说,“不论哪种方法,重要的是认识到能不能解决问题。目前,自动驾驶汽车还不能 100% 的一直保持在车道上行驶。在新环境下,神经网络也不能很好的工作。甚至谷歌汽车也依靠非常详细的地图来识别物体,定位自己。我们还没有达到非常智能的程度来完全理解传感器数据。”

接近黄昏的时候开始下雨了,驾驶员们纷纷打开大灯。很快,湿滑的路面反射了大灯灯光、街灯、商场霓虹灯,还有西沉的阳光,路面看起来像万花筒那样闪烁着各种光芒。自然光在减弱,而夜晚的灯光还不是那么明亮,路面看起来模模糊糊。

雨刮器很久没有工作了,您感觉前面就像涂了泥一样昏暗,路边的阴影也好像挡在了路中央。在朦胧中,您意识到车的盲点范围里有一辆没开大灯的车,您打着转向灯,摸索着向中间车道行驶。突然,您想起了自己的车里应该有先进的主动安全系统。

近期可能出现的三种结果

这个故事可能有三种不同的结果,技术取胜,人战胜机器,还有可能发生事故。可能是这样的:在您认识到将要发生什么之前,转向灯已经开始闪烁,自己的车稍稍向中间车道加速,然后,轻轻的刹车,避开了附近看不到的行人,也提醒了后面的车辆。

也可能是这样:当车轮转向时,您感觉到汽车的车道保持功能在起作用,把车拉回到原来的车道。但是,您仍然继续,打着转向灯,安全的并线,对其他车辆刺耳的喇叭声不闻不问。而此时,行人从路边冒出,前挡风玻璃前视显示系统没有让您及时看到这个人。好在您躲开了他。

或者,可能这样:您转向时,您听到了不熟悉但是非常刺耳的报警声。在您还没有搞明白怎么回事时,一辆车从盲点里鸣着喇叭冲出来—现在,您没有别的选择,只能慌乱的刹车停下来。防抱死刹车功能在湿滑的路面上起作用了,让您感到恐慌,车子终于紧挨着受惊吓的行人停下来了。在极度惊恐中,您瞥了一眼仪表盘,知道了疯狂报警的原因—高级辅助驾驶系统 (ADAS) 关闭了。

这就是同一个场景三种完全不同的结果。这源于三种完全不同的 ADAS 。为说明这些不同,理解其影响,我们将详细研究 ADAS 的实现。在今年的设计自动化大会上,举行了一次主题研讨和公开论坛,对此很好的进行了阐述。

从传感器开始

ADAS 系统是逻辑流水线,要理解它最好从宽输入范围入手。福特汽车电子和电气系统研究主任兼研究员 James Buczkowski 说:“随着向自动化方向的发展,难点在于仅采用一种传感器是远远不够的。”

在公开论坛上,主持人是 Cadence 总编辑 Brian Fuller ,他也要求专家们研讨一下 ADAS 传感器。传感器系统供应商 Nuvation 首席设计工程师 Edward Ayrapetian 认为,“目前我们使用了多种类型的传感器。一般而言,您会看到激光雷达、普通雷达和高分辨率视频摄像机的组合使用。但是随着图像处理算法的改进,所有一切都在不断变化。”

Ayrapetian 解释说,每一类传感器都有其优缺点,其他专家对此也表示同意。例如,激光雷达是谷歌 “无人驾驶” 汽车研究平台的主要传感器。这一技术的标志是激光器和旋转的镜子构成的半个圆球。激光雷达比较擅长勾勒出物体的外形,并提供距离数据—这些都是目标识别算法所必须的。而且,激光雷达对背景光线也不太敏感。

Ayrapetian 提醒说,“但是谷歌使用的激光雷达传感器价格高达 10 万美元。” 而且,在有雾或者下雪等低能见度的时候,从物体表面反射回来的光束所携带的信息量很少,激光雷达就不太好用了。Ayrapetian 提到了非常著名的加州沙漠聚会,“我们把自动驾驶卡车开向‘火人’。我们所知道的是,激光雷达无法识别一大片尘雾和砖墙。”

而雷达在一定程度上是非常好的互补技术。如果您仔细选好了频率、波形和接收信号处理功能,那么,雷达不会受到干扰的影响,实际上在低能见度和光照条件下都能正常工作。大陆汽车系统和技术公司 ADAS 业务部主任 Christian Schumacher 补充说:“雷达能够很好的获得距离数据。但是,雷达不擅长识别物体。” 不太理想的外形数据,而且没有纹理或者颜色信息,这让物体识别算法无法工作。

因此,我们使用了摄像机。随着低成本高分辨率摄像机的出现,视频成为 ADAS 的关键传感器技术,为物体识别提供了丰富的数据。多摄像机系统能够避开某些视觉障碍,提供虽然有限但是足够用的基于视差的距离信息。但是摄像机也有其问题,能见度差的时候无法工作。Schumacher 提醒说:“摄像机对光照要求很高。我们需要找到平衡点—一种在所有驾驶条件下都非常高效的系统,但是不能有太多的传感器。”

通过采用更好的算法来互相补充,以减少传感器。Ayrapetian 说:“我们要考虑传感器所面临的问题及其关键程度来定制传感器。如果把需求缩窄,就能够改进算法。我们基本能够采用更好的视频流图像处理算法来替代激光雷达。”

传感器融合

即使在图像处理技术上有所突破,大家一致认为仍然需要先进的传感器融合技术才能从几种不同类型的数据中,获得车辆周围环境正确的信息:物体,其速度和加速状态,以及可能的行为等。一个重要而且复杂的问题是,在系统中要进行多少次处理。有可能是将所有的原始数据送入融合引擎—例如,卡尔曼滤波器或者深度学习神经网络,看一看能够得出什么。这种想法有一定的可行性,例如实际上有一类特殊的网络,卷积网络,它用在物体识别时的性能非常好。

但是,设计人员更倾向于采用他们在操作层面上能够理解的系统。在5月份举行的嵌入式视觉大会的一次研讨中,谷歌自动驾驶汽车团队的技术主任 Nathaniel Fairfield 说:“我们的策略是开发简单的系统来处理传感器数据,然后,以更抽象的方式来融合经过预处理的数据。我们更愿意通过一个大滤波器来运行所有一切。”

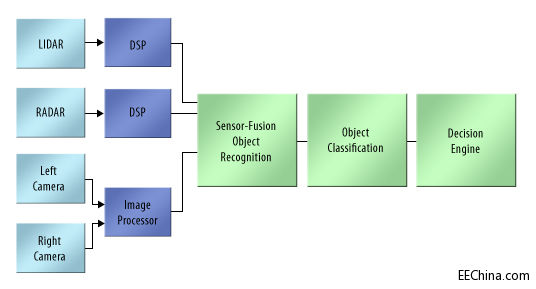

一种简化的方法是对处理步骤进行逻辑排序 (图1)。每一个传感器都会进行本地信号调理,甚至可能根据下游的反馈来自动适应。然后,每一个传感器会在本地根据其掌握的信息进行物体估算,为推断出的这些物体附加一些属性。

图1. 您可以把ADAS看成是处理器流水线,越来越抽象的看待汽车周围的环境。

例如,激光雷达能够确定地面 030 方向有一个物体,从右向左移动,距离大概 20.24 米。雷达也会报告,在同一位置,地面噪声背景上可能有一个物体。一对高分辨率摄像机会看清楚这一物体—看起来非常像一头金色猎犬,方向在 025 至 035 之间,大概 15 米之外。

这些信息会被传送至融合引擎,接收有物体存在这一主视图,附加上最可靠的属性—例如,位置、速度、大小和颜色。这些信息随后会被送至一个分类引擎,将其标示为一条狗—例如,位置、速度、大小和颜色。这些信息随后会被送至一个分类引擎,将其标示为一条狗

这看起来很有逻辑性,但却不能解决问题。甚至在每一阶段采用哪类算法都没有达成一致。Schumacher 观察到:“目前,大部分步骤都是基于规则的。但是,基于规则的系统需要很多支持。我们会看到一些算法采用了人们不好解释的方法。”

本田北美研究所的首席科学家 Victor Ng-Thow Hing 同意这一观点,“深度神经网络在识别任务上会远远超过人,甚至超过基于规则的算法。有些方面会否定规则。我认为应该有一种混合方法。”

Ayrapetian 说,“不论哪种方法,重要的是认识到能不能解决问题。目前,自动驾驶汽车还不能 100% 的一直保持在车道上行驶。在新环境下,神经网络也不能很好的工作。甚至谷歌汽车也依靠非常详细的地图来识别物体,定位自己。我们还没有达到非常智能的程度来完全理解传感器数据。”

Altera 自动化 传感器 汽车电子 Cadence 滤波器 神经网络 嵌入式 DAC 相关文章:

- 基于SoPC的汽车安全监控系统设计(07-09)

- FPGA实现的FIR算法在汽车动态称重仪中的应用(07-15)

- 基于ADPCM算法的汽车智能语音报警系统的设计(08-03)

- 如何进行汽车电子系统中的处理器选择(09-21)

- FPGA到ASIC的整合为车用微控制器带来灵活性(09-25)

- 基于SoPC汽车安全监控系统设计(09-14)