浅谈量子计算机的原理

最近,中国科技大学的潘建伟教授宣布,中国研究团队在去年首次实现十光子纠缠纵的基础上构建了世界首台超越早期经典计算机ENIAC和TRADIC的超导量子芯片计算机。

确实,这在科学界是个可喜可贺的事情,因为这表明中国团队不但在量子通讯领域里处在世界领先位置,在量子计算机的实验上也挤进了第一方阵。同处该方阵的还有谷歌(Google),国际商用机器公司(IBM)和荷兰的Delft技术大学等等。

但是,这个本来挺严谨学术的事情,在一个"不在乎事实,只在乎观点"的时代被不幸的标题党了一下,就变成了大事儿:

人民日报微博的一句"比超级计算机还厉害!"博得了亿万网民的眼球。不过也好,趁机科普一下。

我们还是先看看到底怎么回事吧。先来看图:

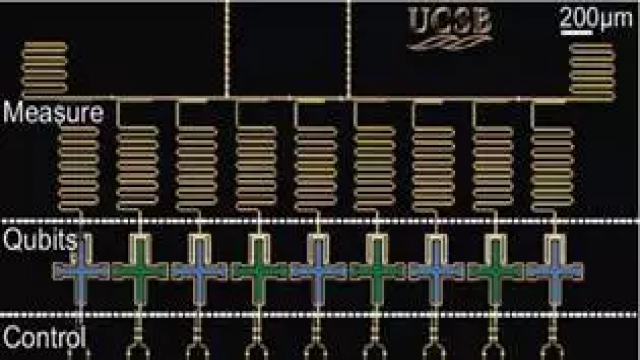

图1,中国团队的10量子比特芯片(2017)

图2,谷歌UCSB的9量子比特芯片(2015)

首先,中国团队的这个10个量子比特的芯片超越了谷歌John Martinis组的9个量子比特。确实是领先的。并且从速度上快了24,000多倍,而且也是第一个比ENIAC快的量子计算机。

不过,这个量子计算机算的是一个叫做Boson Sampling的特定问题,这个和通用量子计算机还是不一样的。

Boson Sampling,"玻色取样",它的计算复杂度是随着粒子数的增加而指数增长的。理论表明,目前最好的商用CPU只能处理约25个粒子的玻色取样,而目前最快的超级计算机"天河2号"能处理约45个粒子。如果量子计算机能够达到100个粒子的相干操纵,那么它对于处理这类问题的能力就可以达到"天河2号"的百亿亿倍!

并且,量子比特不光看数量,还要看质量,其中包括量子比特的纠缠寿命,还有操作灵活性上。

在纠缠寿命(T1)上,中国团队的在10.9ms到27.2ms之间,谷歌UCSB的在18.6ms到39.2ms之间,IBM的在20.4ms到44.4ms之间——中国团队的接近世界先进水平。

从操作灵活性及可靠性上来说,中国团队的芯片就差了一些。中国团队的芯片两个量子比特操作的可靠性只在90%左右,而Google的在98%左右。而在通用量子计算机中,不但寿命要高,操作性更需要达到99%,而且任意两个相邻的量子比特之间都要能自由实现高可靠的两个量子比特的操作。所以,从水平来看应该是伯仲之间,各有千秋。并且,未来还是有很长的路要走的。

所以,我的评价是:潘院士领导的团队进入量子计算机实验领域,从无到有,并且挤入第一方阵。非常棒。另外,虽然我们号称一两年内达到20个量子比特,谷歌团队甚至号称2018年底前搞出50个量子比特。但是量子计算机本身仍属于前途光明,道路曲折的状态。

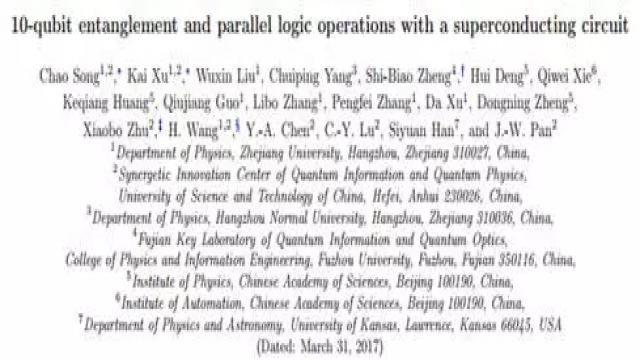

此外,这里我们再加个小插曲哈。请看下图:

图3,文章署名

可以看到,虽然潘院士是最后一个作者(大boss)。但是其实是团结了中科院,浙大等众多单位包括朱晓波、黄浩华等教授。说明潘院士的组织贡献应该大于科研攻关的贡献。

下面,我们来简要介绍一下量子计算机,以便大家更好理解。

(简化得不能再简化的)原理

大家知道,普通计算机用的数据单元是比特,也就是0和1,比如磁极的南北,电容的充放电,电压的高低。

量子计算机呢,用的是量子比特,也是0和1,不过我们这么表示:|0ñ和|1ñ。比如粒子的自旋,光子偏振或者是反射和透射等等。只不过,光子的偏振状态是可以叠加的,也就是说可以一半水平偏振,一半竖直偏振——这种叠加可以是任意比例的。

形象地来看,量子比特其实是分布在一个单位球表面上的任意一个点,可见量子比特所包含的信息比经典比特多得多。

而且,按照量子系统的可叠加性,多个量子比特也可以并行处理运算。当有两个光子的时候,两个量子比特就不止有|00ñ, |01ñ, |10ñ, |11ñ这四个状态,而是可以有这四个状态的随意叠加,比如|00ñ+ |11ñ就表示这两个光子要么一起横偏振要么一起竖偏振,但是不定——这就是所谓的纠缠态。

可见量子比特可以处在的状态的种类比普通比特多多了。那么,这样纠缠的多粒子理论上就可以进行并行计算了。

历史

量子计算机最早的想法是爱捣蛋的美国物理学家费曼在1982年提出来的。(费曼就是那个发现挑战者号航天飞机橡胶圈冻硬导致燃料泄漏引起事故的人。)

费曼发现分析模拟量子物理世界所需要的计算能力远远超过了经典计算机所能达到的能力,而用实验室中一个可控的量子系统(比如:一台量子计算机)来模拟和计算另外一个我们感兴趣的量子系统,会非常高效。

- 谈播出网络利用串口传输已播出文件(06-13)

- 基于TCP/IP通信协议的计算机网络安全与防范(03-14)

- 物联网时代的计算机网络技术教学探究(08-10)

- 浅析计算机网络网速缓慢的原因(06-25)

- 一种高可靠性的计算机与FPGA串行通信的实现(12-21)

- 网络计算机中IC卡读写器子系统设计(05-20)