AI机器人画画,谷歌要培养艺术系机器人了吗?

机器学习是谷歌所采用的各种工具最广泛的一个概念。它是通过编程让计算机自学如何执行各种不同的任务的一种方式,常见的方式是给计算机注入标签数据来进行"训练"。进行机器学习的一种热门方式是,借助以人脑的连接系统为原型的神经网络。不同的节点(人工神经元)会相互连接,它们有着不同的权重,会响应部分输入信息,但不响应其它的输入信息。

近年来,多层级神经网络被证明在解决棘手的问题上非常成功,尤其是在翻译和图像识别/操纵上。谷歌在这些新架构上重新构建了很多的核心服务。这些神经网络模拟人类大脑的运作过程,其互相连接的层可识别输入信息(比如图像)不同的模式。低级别的层可能含有响应光明与黑暗简单的像素级模式的神经元。高级别的层则可能会响应狗的脸、汽车或者蝴蝶。

构建带有这种架构和机制的网络会带来不可思议的成效。原本极其困难的计算难题变成了调整模型的训练,然后让一些图形处理单元运算一会的问题。正如吉迪恩·刘易斯-克劳斯(Gideon Lewis-Kraus)在《纽约时报》所描述的,谷歌翻译(Google Translate)曾是一个开发超过10年的复杂系统。该公司后来利用深度学习系统仅仅花了9个月就重新构造了一个谷歌翻译系统。"该AI系统一夜之间就有了巨大的提升,这种提升相当于老系统在整个生命周期积累的全部提升。"刘易斯-克劳斯写道。

正因为此,神经网络的使用量和类型呈现井喷式增长。SketchRNN方面,他们使用可处理输入序列的递归神经网络。他们用人们画各种不同的东西时连续画下的笔画来训练该网络。

用最简单的话来说,这种训练就是一个编码的过程。数据(绘图)输入之后,该网络会尝试想出它在处理的东西的一般性规则。那些概括是数据的模型,数据存储在描述网络中的神经元的倾向的数学计算当中。

那个结构被称作潜伏空间或者Z(zed),是猪的特征或者卡车的特征又或者瑜伽动作的特征方面的信息存储的地方。正如AI行业人士所说的,叫系统做个样本,即叫它画出它训练的东西来,SketchRNN就会画出猪或者卡车又或者瑜伽动作。它所画的东西,就是它所学到的东西。

SketchRNN能够学到什么?

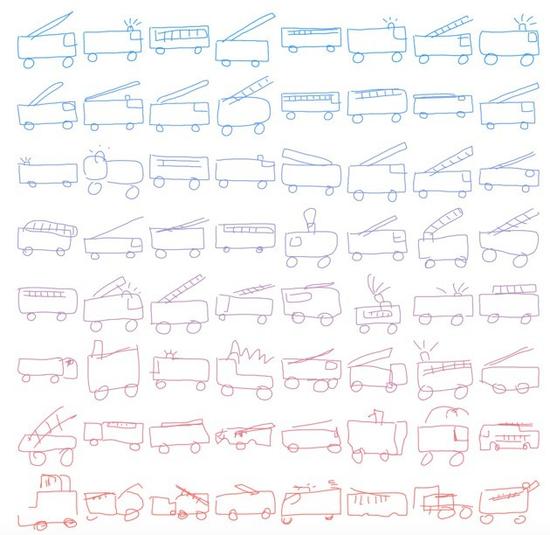

SketchRNN能够学到什么呢?下图是一个接受过消防车绘画训练的神经网络所生成的新消防车。在该模型中,有个名为"温度"的变量,它可让研究人员上下调整输出的随机性。在下图中,偏蓝色的图像是"温度"下调后的产物,偏红色的图像则是"温度"上调后的产物。

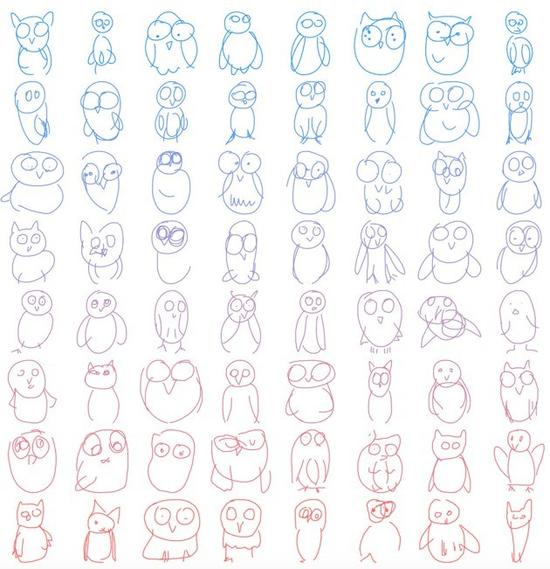

又或者,你可能更喜欢猫头鹰:

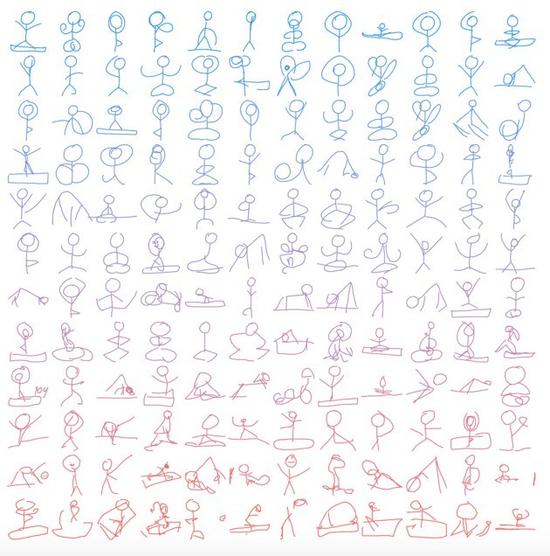

最好的一个例子就是瑜伽动作:

这些画看似人的作品,但它们并不是由人亲自绘画的。它们是对人类可能会如何画这种东西的一种重造。有的画画得很不错,有的则画得没那么好,但如果你是在跟AI玩看图说词游戏,那你应该不难看出它们是什么。

SketchRNN还能够接受以人工绘图为形式的输入。你传送某种绘图,然后它就会尝试去理解它。如果你给一个接受过猫数据训练的模型输入一张三眼猫绘图,那会发生什么呢?

看到没?看该模型在右边的各种输出图像(同样用蓝色和红色来表示不同的"温度"),它剔除了第三只眼睛!为什么呢?因为该模型已经通过学习知道,猫有两只三角形的耳朵,脸部左右两边都有胡须,脸圆圆的,只有两只眼睛。

当然,该模型完全不知道耳朵实际上是什么东西,不知道猫的胡须是否会动,甚至不知道脸是什么,也不知道我们的眼睛能够将图像传输到我们的大脑。它对于这些绘图指代的是什么一无所知。

但它确实知道人类是如何表示猫、猪、瑜伽动作或者帆船的。

"当我们开始生成帆船的绘图时,该模型会基于所输入的那张绘图得出数百张显示其它帆船模型的绘图。"谷歌的艾克表示,"我们都能看出它们画的是什么,因为该模型是利用所有的训练数据得出理想的帆船图像。它并不是画出特定的帆船,而是画出帆船的特征。"

成为人工智能运动的一份子是一件令人兴奋的事情,它是有史以来最令人兴奋的技术项目之一,至少对那些参与其中的人来说是如此,对于很多其他的人来说也是如此--它甚至能够击倒道格·艾克。

我是指训练神经网络画雨天。输入一副蓬松的云绘图,然后就会出现下面的情况:

雨从你给该模型传送的云下下来。那是因为很多人画雨天的时候都是先画出一朵云来,然后再在下面画雨。如果该神经网络看到云,那它就会在那个云的形状下面画出雨来。(有意思的是,那些数据是关于一连串的笔画,因此如果你先画的是雨,那该模型就不会先画云朵。)

这可以说是一项令人

- 谷歌智能隐形眼镜凸显传感器价值(01-14)

- 如果智能硬件没有传感器...(01-08)

- 无人驾驶,依赖地图不如依赖传感器(02-09)

- 谷歌又有黑科技专利,这次传感器玩的有点大(04-06)

- 意法半导体运动传感器获得谷歌Daydream和Tango两大平台认证(10-02)

- 谷歌人工智能机器人秀完美“走位”(06-12)