多旋翼无人机干货来袭,这次是传感器技术

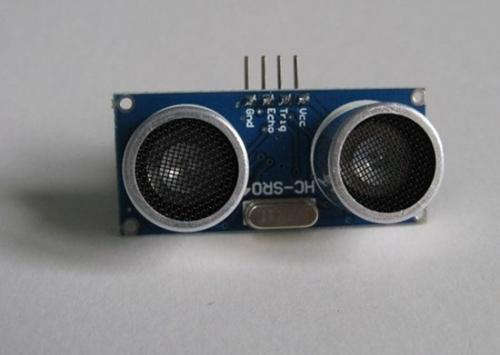

测量回波的时间,能够算出导致声波反弹的物体离探头的距离。现在在淘宝上,只要10块钱就可以买到一个能够比较准确测量几米内物体距离的超声波模块,被广泛用在大学生制作的小机器人上。这种10块钱的传感器没有比气压计和MEMS惯性测量元件性能高多少,它发出的声波容易发散,探测到的物体不一定位于探头正前方,另外声波也容易被空气中的水雾、振动所影响,给出完全错误的观测。因此,超声波模块最好的使用场景是对着地面,测量自身和地面的距离。

3. 视觉感知系统

另外一种替代品是视觉感知系统。1970年之后,随着数字成像技术的发展,相机作为一种传感器开始被广泛研究。因为人可以通过自己的视觉估计视野中物体的位置、距离,而相机的原理模拟了人的双眼,所以研究者们模仿人的特点,利用相机的二维图像反推图像中物体的三维信息。这种和二维图像推算三维信息相关的技术和数学理论发展成了一个独立的学科--计算机视觉,也被称作机器视觉。

视觉感知系统是目前世界上最热门的机器人学和机器视觉领域研究课题。其原理是利用一个或者多个相机构成的视觉传感器系统,采用复杂的算法,通过二维的相机图像推算出视野中物体相对与视觉传感器系统的几何中心的运动信息,如果假设这些物体都是静止的,那么相对运动其实代表了视觉传感器本身的运动。理论上,计算机视觉技术能够单凭一个相机就可以准确测量十五个状态量,但是与其他传感器类似,相机也有很多的缺陷,包括无法恢复尺度、成像质量有限、计算量消耗巨大等等。幸好,我们还可以把视觉感知系统和其他传感器结合起来,互相提高测量精度。

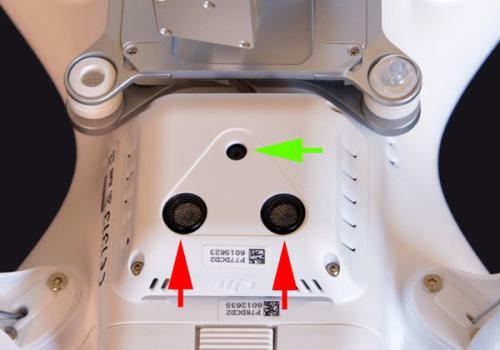

聪明的读者肯定能够想到,把视觉感知系统和之前说的所有组合导航中用到的传感器融合起来,GPS信号质量高的时候用GPS组合导航,没GPS的时候用视觉感知系统替代GPS,不就解决问题了吗。这确实正是目前工程师和科学家们正在努力解决的问题,也是精灵4上初步实现的技术。在介绍精灵4是如何结合视觉感知系统和组合导航技术之前,我们先简单介绍两种已经比较成熟的视觉感知系统:光流测速模块和视觉里程计。

光流测速模块顾名思义,只能测速度。通常一个光流测速模块由一个相机、一个惯性测量元件、一个超声波模块构成,它的主要原理是计算机视觉技术中于1981年被发展出来的"光流追踪"算法。

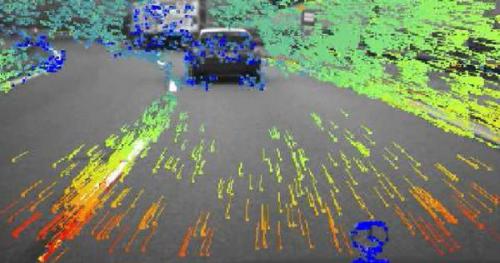

"光流"的概念最早在1950年代由心理学家和生物学家提出,指的是一个观察者和他在观察的事物发生相对运动时,这些事物在他眼前成的像会产生"运动的模式",人脑利用这种"运动的模式"能够更灵敏地感知周围什么东西在动。比如下图中,读者一看就可以直观理解"光流"的意义。

后来计算机科学家布鲁斯-卢卡斯和金出武雄在1981年发明了Lucas-Kanade算法,通过算法计算出连续拍摄的图片上的光流,并证明了光流可以反解出相对运动的速度。虽然三十多年来,Lucas-Kanade算法始终被公认为最好的"光流追踪"算法,但是它有比较大的局限性,它包含很多假设,比如假设连续图片的平均亮度相同,比如假设图片中的物体只发生平面运动等等。另外,光流算法算出的速度是没有尺度的,因为相机图像的单位是像素,所以光流算法只能给出"你现在的速度是10个像素每秒",但是没法算出10个像素是1厘米还是1米。恢复尺度的方式是增加一个超声波模块测量平面运动离相机的距离,这样就能够把像素运动转换成真实的运动。最后,如果要让光流测速模块在晃来晃去的多旋翼飞行器上也能使用,通过惯性测量元件找出图像所代表的平面也是必不可少的,这一点需要在算法上进行两种传感器很好的配合。

光流算法原理上只可以测三维速度,不能直接测量三维位置。我们同样可以通过把光流测速模块测出的三维速度积分获得三维位置,但是就像惯性测量元件积分会发散一样,光流测速模块积分得到的位置也会发散。好在它不会天马行空地失去控制,和组合导航技术中除了GPS之外的传感器妥善融合之后,它可以做到悬停时测量的位置不发散。因此可以说光流测速模块只在有限的条件下能够替代GPS。

光流测速模块已经形成了非常标准的解决方案。大疆悟以及精灵3上都装载了自主研发的光流测速模块,另外著名的开源飞控产品Pixhawk中包含了一个叫做PX4Flow的光流测速模块,并且开源了所有的代码和硬件方案。所以光流测速模块目前已经广泛出现在了各大厂商的多旋翼飞行器产品上。

视觉里程计相比光流测速模块,增加了直接测量位置的能力,所以才叫"里程计"。视觉里程计比光流测速模块能力更强,性能更好。

读者

- 让AI前往广袤宇宙,NASA为人类寻找下一个家园(07-31)

- 大热的四轴飞行器设计,提供软硬件参考方案(09-20)

- 传感器和致动器正成为元器件市场新热(03-12)

- 图像传感器市场突破60亿美元,CMOS将占主导地位(05-22)

- 超低功率“智能尘埃”创新无限,无线传感器技术继续高歌猛进(05-22)

- 电化学气体传感器核心技术见突破(05-26)