一个射频工程师应该有怎样的基本功?

曾经有一次收到工厂实验室的测试报告,发现让他们测的传导杂散的一塌糊涂。大家一看结果炸锅了,因为这结果打死也过不了认证。

因为测试setup不是我指导的,所以我也搞不清楚究竟发生了什么,所以就换了工衣去实验室看看。

进去了之后看了他们的信号连接,发现全是坑。

首先是他们把发射信号直接捅到频谱仪上去了。

第一件事就是让他们把发射功率关了。

我问他们为什么要这么干,他们说一方面用频谱仪监测Tx power,然后切到带外看杂散。

算了一下,从天线口到频谱仪,算上双工器线缆衰减器,到频谱仪口上的功率16dBm——算上峰均比超过20dBm,还好勉强不会烧坏频谱仪(一般限制是30dBm)。

事实上频谱仪原本是个测小信号的东西,靠的是底噪低,用来测大信号的话一定要先用衰减器减下去,0dBm左右测的好好的,倒是信号大了容易失真,更不用说直接一个大功率杀进去可能就把输入端口烧坏了。

我于是告诫他们频谱仪的输入功率不能太大,保护仪表是第一。

然后他们重新接线,动作还是很麻利的,然后接好之后,告诉我他们加了20dB衰减在上面——意思是这下终于不会烧仪表了。

我问他们要测的杂散大概功率多高,他们拿出一张表格来,上头赫然列着一堆limits,基本上都在-60dBm左右。

好吧,那么我们来算算:按照1MHz RBW算,你要测一个-60dBm的信号,与此同时旁边还有一个16dBm的信号,这么算来动态范围得要80dB。

所谓动态范围,是指从噪底到"最大无失真电平"的区域,在我们这个情况下,意味着保持所有AGC不变的情况下,既要测到-60dBm的杂散,还要保证16dBm的信号不会成为一个blocking而阻塞掉频谱仪的接收机。

然后大家认为最直接的解决方案就是继续加大衰减,这样让频谱仪入口的电平再低一些,就不会有射频失真了。但是这样另一个问题就来了——噪底。

按照一般频谱仪噪底-150dBm/Hz,折算1MHz RBW应该是-90dBm的噪底,这时候你要测到一个-60dBm的信号,那么至少你要让被测信号落在噪底10dB以上。如果你一不小心加了30dB的衰减,那么杂散的电平恐怕就已经淹没在仪表噪底的汪洋大海之中了。

所以当我们要测试一个小信号的时候,必须要考虑噪底的问题:这个噪底的来源可能有两个,被测信号的噪底或者频谱仪的噪底,如果你希望检测到一个很低的信号,那么就必须保证这个信号不会被频谱仪的噪底淹没——提高频谱仪噪底的方法有多种:减小衰减,打开预放,等等。而为了保证在尽量小的衰减下频谱仪不至于被大信号blocking,我们需要有个办法干掉主信号。

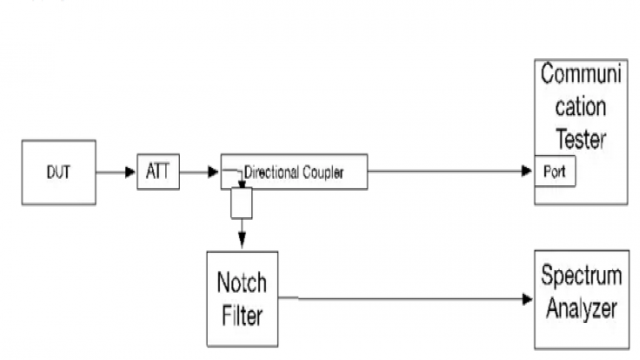

所以我画了这个图:

图里面最重要的其实是三件东西:衰减器,定向耦合器和陷波器(就是带阻滤波器)。

定向耦合器的作用是"在尽量不损失主信号的前提下将被测信号分出一部分",这样主信号依然可以通过直通端进入综测仪,我们可以监测功率是否准确。

陷波器的作用则是"将不需要的主信号咔嚓掉,为频谱仪提供足够的动态范围和足够好的噪声底",当然陷波器一定不能把待测的杂散信号一块咔嚓掉的。

衰减器的作用——先等等,放在后面说。

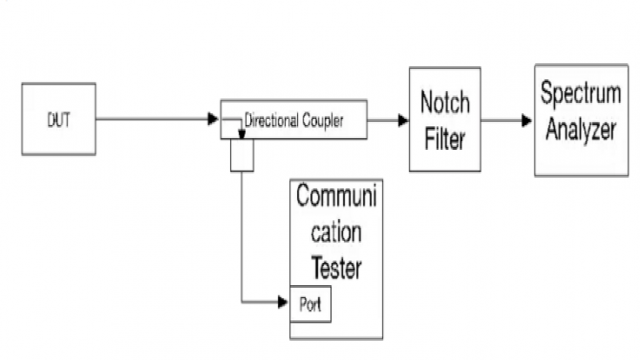

然后有人给我画了一张这样的图:

貌似频谱仪也不会过载,而综测仪也能监测功率?

而且他们觉得这样用定向耦合器的耦合度替代了衰减器,一举两得。

然后他们会惊异的发现杂散(尤其是谐波)一塌糊涂——在工作的十二年间,我发现无数工程师、包括一些年头不短的或者学历很高的工程师,不知道陷波器端口上在阻带内的特性:RL很大,近乎全反射。如果像上面图那样做测试,DUT的发射功率有很大一部分被反射回去了,PA工作在严重失配的条件下,各种失真丛生。

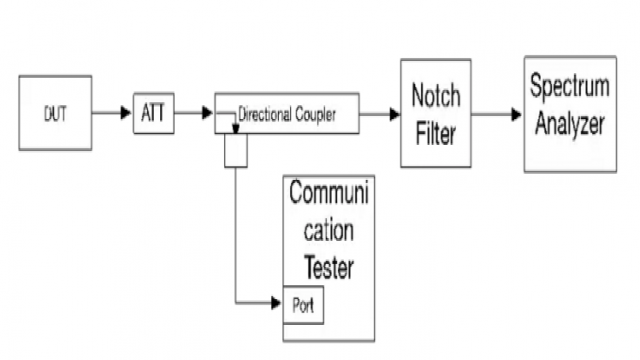

假如修改一下,DUT输出加一个衰减器,会好一点:

因为这样的链路,Tx信号首先经过了xdB的衰减,再被反射回来,又经过xdB衰减,才落回到DUT端口——这样真正被"打回来"的功率被削掉了2*xdB。

当然,最好的设置依然是第一张图那样。

所以在我们第一张图(标准设置)里,DUT输出就是直接接了一个衰减器的,这个衰减器的作用就是为了减少无处不在的失配对DUT发射机的影响。以前做功放,我们总是习惯在板对板连接器(可能产生失配和不连续)后面放上一个Pi衰减,不用很大,2~3dB就足够让回波损耗优化很多。

话说回来,你们觉得这些东西书上会教吗?显然不会。但是如果书上的内容都吃不透,你也没有基础可以想到这些。只是,念了那么多年书出来,每天坐在办公室,不

- RF功率放大器那点事(07-08)

- 射频工程师应该要掌握的测试测量技能(11-22)

- 欲玩转Power Class 2?这些要点必须知!(04-24)

- 射频工程师必读:S参数进阶(04-17)

- 射频工程师应该掌握的“猜”的技能(05-19)

- 从两个射频测试的题目谈射频工程师的基本功(05-19)