漫谈游戏的深度学习算法,从FPS和RTS角度分析

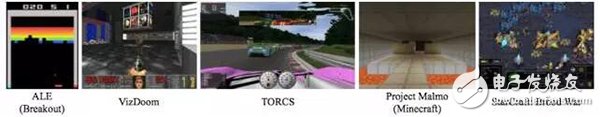

生动,但这个环境目前没有 ALE 那么流行。

图 1. 作为深度学习研究平台的几款游戏的截图。

B. 竞速游戏

竞速游戏中,玩家控制某种车或某个人物在最短的时间内到达目的地,或者在给定时间内沿轨道行驶最远的距离。通常情况下,该游戏使用第一人称视角或玩家控制车辆的后方有利的位置作为视角。

竞速游戏中的一个普遍挑战是智能体需要利用微调后的持续输入来控制车辆的位置,调整加速或刹车,以尽快走完轨道。这至少需要短期规划、一次或两次转弯。如果游戏中还需要管理其他资源,如能源、破坏或提速,则还需要长期规划。如果轨道上出现其他车辆,还需要加入对抗规划,以管理或阻止超车。

带 3D 图像的视觉强化学习经常使用的环境是开源赛车模拟器 TORCS [121]。

C. 第一人称射击游戏(FPS)

近期,第一人称射击游戏(FPS)设置成为适合视觉强化学习智能体的先进游戏环境。与 ALE 基准中的经典街机游戏相比,FPS 具备 3D 图像,状态部分可观测,因此是更加生动的研究环境。通常的游戏视角是玩家控制的人物的视角,但 FPS 范畴内的多款游戏采用了过肩视角。这种设计造成的挑战是快速感知和快速反应,尤其是看到敌人并快速瞄准时。但是也存在其他认知挑战,包括在复杂的三维环境中定向和移动,预测多个敌人的动作和位置;某些游戏模式还需要团队合作。如果游戏中使用了视觉输入,那么从像素中抽取相关信息也是一个挑战。

ViZDoom 是一个 FPS 平台,该框架允许智能体使用屏幕缓冲作为输入来玩经典的第一人称射击游戏 Doom[50]。DeepMind Lab 是一个基于《雷神之锤》(Quake III)Arena 引擎的三维导航和解谜任务平台 [2]。

D. 开放世界游戏

开放世界游戏,如 Minecraft、Grand Theft Auto V,这类游戏的特点是非线性,有一个很大的游戏世界供玩家探索,没有既定目标或清晰的内在次序,玩家在既定时间内有很大的操作自由。智能体的关键挑战是探索游戏世界,设定真实、有意义的目标。鉴于这是一项非常复杂的挑战,大部分研究使用这些开放环境探索强化学习方法,这些方法可以重用和迁移学得的知识到新的任务中。Project Malmo 是一个根据开放世界游戏 Minecraft 构建的平台,可用于定义多种复杂问题 [43]。

E. 即时战略游戏

这类游戏中玩家控制多个人物或单元,游戏目标是在竞赛或战争中获胜。即时战略游戏的关键挑战是制定和执行涉及多个单元的复杂计划。这个挑战通常比经典棋类游戏如象棋中的规划挑战更难,因为多个单元会随时移动,有效的分支因子通常非常大。另外一个挑战是预测一个或多个敌人的移动,敌人本身就有多个单元。即时战略游戏(RTS)在战略游戏本就很多的挑战之上又增加了时间优先次序(time prioritization)的挑战。

星际争霸游戏系列无疑是即时战略游戏中研究最多的游戏。《星际争霸·母巢之战》的 API(BWAPI)使软件可以在游戏运行中与星际争霸交流,如抽取状态特征、执行操作。BWAPI 曾广泛应用于游戏 AI 研究,但是目前只有少数使用了深度学习。近期根据 BWAPI 构建的库 TorchCraft 将科学计算框架 Torch 和 StarCraft 联系起来,使用机器学习方法研究该游戏 [106]。DeepMind 和暴雪(星际争霸的开发者)已经开发了机器学习 API,以支持机器学习在星际争霸 2 中的研究 [114]。该 API 包含多个小挑战,尽管它支持 1v1 游戏设置。有两个抽象出来的 RTS 游戏引擎值得一提:RTS [77] 和 ELF [109],后者实现了 RTS 游戏中的多个特征。

F. OpenAI Gym & Universe

OpenAI Gym 是一个对比强化学习算法和单独接口的大型平台,该接口包含一系列不同的环境,包括 ALE、MuJoCo、Malmo、ViZ-Doom 等等 [11]。OpenAI Universe 是 OpenAI Gym 的扩展,目前可以接入一千多个 Flash 游戏,并且计划接入更多现代电子游戏。

玩游戏的深度学习方法

A. 街机游戏

街机模式学习环境(ALE)已经成为深度强化学习算法直接从原始像素中学习控制策略的主要试验平台。本节概述 ALE 中的主要进展。

深度 Q 网络(DQN)是第一个在 Atari 游戏中展示人类专业玩家控制水平的学习算法 [70]。该算法在七种 Atari 2600 游戏中进行测试,表现优于之前的方法,如具备特征构建 [3] 和神经卷积 [34] 的 Sarsa 算法,并在三种游戏上表现优于人类专业水平。

深度循环 Q 学习(DRQN)在输出前使用循环层扩展 DQN 架构,这对状态部分可观测的游戏效果很好。

Q 学习算法存在一个问题,即它通常高估动作值。基于双

- 机器学习算法盘点:人工神经网络、深度学习(07-02)

- 2016年人工智能与深度学习领域的十大收购(07-26)

- AI/机器学习/深度学习三者的区别是什么?(09-10)

- 深度学习的硬件架构解析(10-18)

- 麻省理工科技评论评选的14大医疗领域突破科技(上)(10-14)

- 探秘机器人是如何进行深度学习的(09-18)