英伟达GPU笑傲AI芯片江湖,三大类芯片都有搏一搏的机会?

"对于Data center的training和inference系统来说,竞争已经不是在单一芯片的层面了,而是看能否扩展到exascale的问题(exaFLOPS,10的18次方)。而和TPU2的同时发布TensorFlow Research Cloud (TFRC),对于发展TPU2的应用和生态,才是更为关键的动作。"

所以,除了基本的需求,比如Training需要的强大处理器能力,高精度,高灵活性;Inference需要的低延时,高吞吐率,高功耗效率这些因素之外;对于异构的大规模分布处理系统的Knowhow已经生态系统的建设也非常重要。而这一点往往是Startup非常欠缺的。

不过,个人还是比较看好国内的这块市场的。第一,目前很多中国的互联网巨头(包括很多小巨头)都把AI作为重点发展的方向,也有非常实际的需求,比如下图就是蚂蚁金服在GMIS上介绍的AI业务。

第二,从竞争态势来说,目前是NVIDIA一家独大,利润空间很大;Intel虽然也有很多动作,但多长时间能推出可以和NVIDIA抗衡的产品还很难说。第三,国内目前对server芯片自主设计的呼声很高,容易得到国家支持。相对server CPU(已经有海光和华芯通在做)的复杂度和生态环境,Machine Learning专用芯片在技术实现和应用渗透方面都要简单不少(Google的TPU就是个很好的例子)。所以,目前这个领域对于国内公司来说是值得一搏的机会。成功立足的话,很有可能做大做强。不过这个领域需要大量烧钱,必须有资本实力作保障。

总的来说,不管是从技术层面,还是资金层面来看,如果能找到一个有一定规模和实际需求的互联网公司合作,也许是成功的关键。

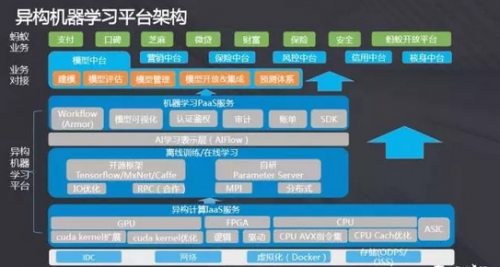

最后,Cloud端还有一个比较有趣的市场:基于FPGA的inference应用(比如对图像、连续视频和语音的检测和识别,实时翻译等等)。这类应用除了需要强大的处理器能力能力外,对实时性要求非常高。这类应用对成本不是很敏感,适合用FPGA来。首先,通用的GPU做inference,不一定能满足实时性的要求,而针对特定应用优化过的FPGA设计,inference效率会高很多;其次,和用专用的芯片做inference对比,FPGA的灵活性又有很优势,改变算法或者网络的成本很低,非常适合人工智能领域的快速发展和变化;第三,FPGA进入Cloud市场是个趋势,目前Amazon,阿里云和腾讯云都开始提供(或者试用)FPGA资源,机器学习应用是一个重要内容。而FPGA的固有缺点:成本高,能耗大(和专用芯片相比),在这个应用场景下基本可以忽略。在今年的GMIS上,蚂蚁金服介绍了他们的机器学习平台,其中FPGA已经是重要的组成部分。

以上分析只是个人一点浅见,如果有不对的地方,欢迎大家批评指正,也欢迎大家和我交流。

更多最新行业资讯,欢迎点击《今日大事要闻》!

- 大尺寸面板价格不涨反跌 市场供需失衡难落幕(07-29)

- Fairchild推出全新品牌,标志着公司的重大转型(03-19)

- 飞兆半导体附属公司崇贸科技荣获发明创作奖(05-14)

- Fairchild通过收购Xsens将战略步伐跨入 快速增长的3D运动追踪市场(05-15)

- Fairchild宣布2014年度北美洲和亚洲功率技术研讨会时间表(04-15)

- Fairchild与Xsens的结合水到渠成(06-09)