“京”的水冷

【日经BP社报道】日本理化学研究所与富士通合作开发的新一代超级计算机“京”*1是日本的国家计划。2011年11月,“京”的理论运算处理性能达到了10.51PFLOPS(千万亿次浮点指令,每秒进行1.051京次浮点运算),连续两次在LINPACK*2基准测试TOP500中名列榜首。

*1 在开发初期,NEC和日立制作所也参加开发矢量型超级计算机,但是因开发费负担重,NEC和日立于2009年5月退出(日立是按照与NEC签署的协议参与计划)。最终只剩下理化学研究所与富士通,利用标量型开发世界最快系统。而且,因为2009年11月行政刷新会议的业务甄别,该系统的开发几乎冻结。

*2 LINPACK 联立一次方程的解法程序,在排出超级计算机速度世界排名TOP500时使用。TOP500于每年6月和11月发表,京在2011年6月和11月蝉联世界最快的超级计算机。

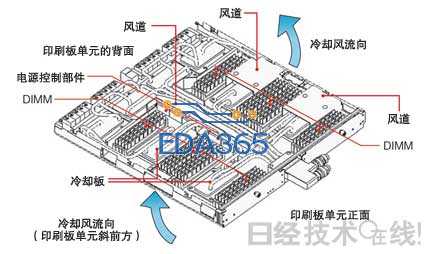

京是最终构成结合了88,128个CPU的巨型并行计算机。内嵌24枚系统板的机架数量多达864个,每枚系统板上都安装了4个CPU(图1)。

图1:设置在理化学研究所中的超级计算机“京”

以10PFLOPS的运算性能登上世界第一的“京”由864台机架构成,位于兵库县神户市湾岸人工岛上的理化学研究所计算科学研究机构。右侧为机架的内部构造。上下各插有12枚系统板,从前向后供应冷却水

在高超的运算性能的背后,并非只是处理性能达到128GFLOPS的CPU、为实现并行处理结合了CPU和存储器的LSI(大规模集成电路)——ICC(互连控制器)等电子技术。为发热体高效降温的冷却系统也发挥着重大作用。

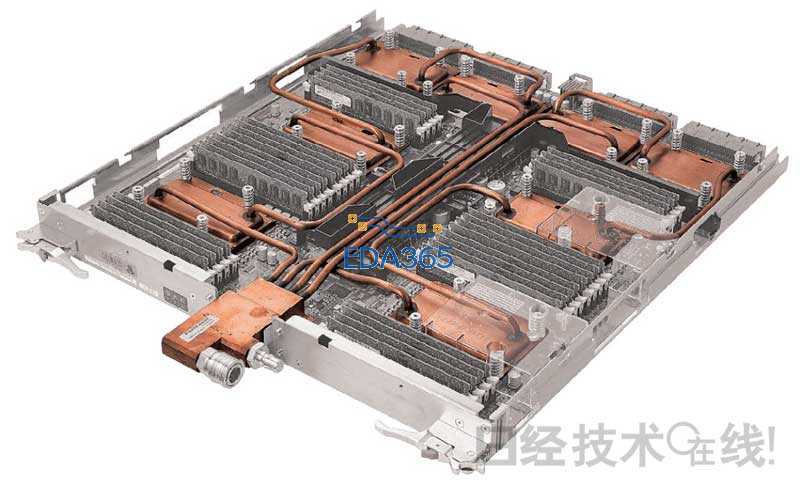

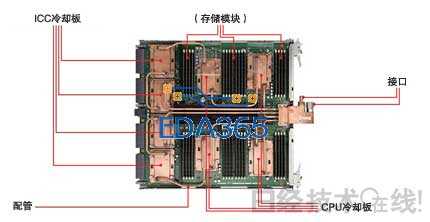

而尤为重要的,是应用于CPU和ICC等高发热密度部分的水冷技术。京的水冷系统能够分别向800多个机架供应冷却水,把冷却水分配给机架内的24枚系统板。各系统板都安装了冷却单元,冷却单元经配管与8枚冷却板相连,冷却板与CPU和ICC接触为其降温。这种冷却单元是京的冷却系统的核心部分(图2)。

图2:冷却单元的构成

8枚冷却板覆盖在CPU和ICC上方,彼此由配管相连。配管顶端为供水系统、排水系统2个接口。每个接口伸出2根配管,分别通入2个CPU和2个ICC的冷却水。

其实,对于富士通,大型计算机水冷技术是“即将遗忘的技术”。要想令已经停止持续开发的技术复活,并将其应用于前所未有的新型计算机,就需要克服各种各样的课题。

水冷技术再度成为焦点

“1980年代的大型计算机全都是水冷”(富士通先进技术HPC应用推进统括部统括部长铃木正博)。对于当时的大型计算机,ECL(射极耦合逻辑)类型的LSI是主流。ECL的发热量大,必须使用冷却性能高的水冷。

然而,随着CMOS(互补型金属氧化膜半导体)在1990年代之后问世,大型计算机对于冷却的需求发生了改变。CMOS只在工作时发热,因此,“空冷也可以满足需要”(铃木)。而空冷的设备成本也比较小,水冷技术逐渐淡出了大型计算机。

而此次京的开发却把目光投向了水冷技术。这是因为开发的目的是实现前所未有的高运算性能,而且设置空间有限。

有研究表明,计算机的运算性能温度每降低1℃,性能将提高0.2%。也就是说,如果温度能够降低50℃,性能就有望提升约10%。而且,通过进一步冷却,还可以降低CPU的故障率。一般来说,CPU的温度降低10℃,故障率将会减半。对于8万多个CPU联动的京,确保CPU的可靠性是系统稳定运行必不可少的条件。

冷却虽然也可以利用向翅片送风的空冷方式实现,但设置翅片需要的空间与水冷差别巨大。例如,在冷却性能相同的情况下,空冷翅片需要的空间是水冷冷却板的10倍。

在京还在开发之中时,设置位置就已经确定,冷却系统必须能够放入空间。鉴于能够实现运算性能目标的CPU和ICC数量庞大,其安装密度相当之高。

具体来说,各配备了4个CPU、4个ICC、32枚存储模块的24枚系统板需要容纳在宽度、纵深不到750~800mm,高度约为2m的机架中。而且,机架内还必须容纳电源等装置。

为了满足需要,如上所述,冷却系统采用了从整体向机架、系统板、CPU和ICC逐级分岔的形式。对于开发方富士通而言,为京开发由总长70km的铜配管、23km的橡胶配管,以及50万个接头组成的水冷系统是一项巨大的挑战。

借鉴老技术

“当时,曾经从事大型计算机水冷技术的技术人员有几十人。但随着计算机冷却的主流变成空冷,这些技术人员逐渐调往存储等部门,分散到了公司的各个角落”(富士通新一代技术计算开发本部系统开发统括部第一开发部部长高田恭一地)。京的水冷系统的开发就是在这种情况下开始的。

“使用什么冷却材料能够降温多少”、“如何评价配管材料的腐蚀性并选择软管”,汇总这些技术经验的文件应该还在这个世上,“但却不知道放在哪里”(高田)。

于是,开发人员开始咨询过去从事过水冷技术的技术人员。当然,单是挖掘过去的技术并不能实现京的冷却系统。因为京对于发热量、设置空间的要求都比过去更加严格。

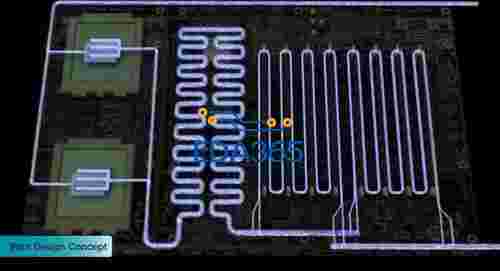

以前面提到的与8枚冷却板经配管相连,端部安装了接口的冷却单元(图2)为例。冷却板虽然铺设在CPU和ICC的上表面,但其内部构造采用了使用微细加工技术在金属板上形成流路的微通道方式。这是富士通在1999年上市的通用计算机“GS8900”上采用的技术*3。

*3 GS8900为了提高处理性能而令水冷技术一度重生。

微通道的具体流路虽然没有公开,但有消息表明,京的流路与GS8900相比有了更大的改进。加工技术和热流体仿真技术也在这10年间大幅进步,通过使用这些技术,设计出的流路冷却效果超过了以往。

配管复杂的路径

冷却单元的配管并不是以最短的距离连接冷却板。负责生产的合作公司甚至抱怨“为什么非要这么弯弯曲曲的”。因为这样做制造需要使用特殊的夹具和方法(图3、4)。

图3:冷却单元与封装分离

冷却单元固定在金属底座上运抵组装地。然后使用装卸用夹具取出单元,在清除冷却板背面(与CPU/ICC接触的面)的异物后,准备就此结束。

图4:冷却单元的安装

在CPU和ICC上表面固定导热片后,在固定于夹具上的状态下确定冷却板的位置。使用螺丝把冷却板固定在系统板上,然后松开装卸夹具,完成组装。

采用这种弯曲复杂的配管路径大致是出于对3个因素的考量。第一,控制流量使CPU和ICC均匀冷却。冷却系统需要对供应给各机架的冷却水进行分配,包括连接冷却板的配管在内,对机架内200多个CPU/ICC均匀进行冷却。

冷却水吸收热量后,其温度将逐渐上升。如果只是简单串联,流路后半段的CPU/ICC就很难得到冷却。再加上可靠性和成本方面的考虑,单凭流路控制冷却水的流动方式成了开发的目标。具体方式是在接口之后把流路分成两条,每条流路以对为单位冷却CPU/ICC。

第二,避开存储器等其他部件。系统板上配备的存储模块的高度几乎等于系统板之间的间隔。配管无法在存储模块上方通过(图2)。

第三个因素是吸收挤压冷却板的8个部件(CPU和ICC)的高度差。CPU/ICC的上表面“存在数μm到数十μm左右的高度差”(高田)。把冷却板压在各部件的上表面时,高度差需要由配管的柔软性吸收。如果配管过短,应力就会集中到配管的根部,可能造成破损。要想使配管在不受损的情况下通过变形吸收某种程度的位移,那配管就要具备一定的长度。

关于柔软性,配管的直径也做了反复尝试。虽说直径细的配管柔软性大,但是,“直径如果达到5mm,安装时就会变得软塌塌”(高田)。最终得到采用的直径是6.35mm(1/4英寸)。

高密闭率成为障碍

系统板在维护时需要从机架中取出,因此采用的是通过接口拆卸的方式。拆卸要求绝对不漏水,但在选择接口时,却碰到了意想不到的麻烦*4。

*4 接合部的密闭性从高到低依次是不锈钢焊接、钎焊、O环密封、粘着性密封胶。富士通的方针是尽可能采取高密闭性方法。例如,构成冷却单元的部件间(冷却板与配管等)采用焊接和钎焊。在更换系统板等时候需要取出的部分使用能够实施O环密封的接口等。

最初采用的是“取出时完全不漏液,而且不透空气的类型”(高田)。但在实验中,接口却发生了破损。

进行冷却时的冷却水温度会升温膨胀。更换时如果在该状态下取出,因为与周围存在温差,冷却水将会降温、体积缩小,使阀门部分承受巨大的压力。这就是接口破损的原因。

鉴于此,接口改换成了密闭性比当初略低一级的类型。当冷却单元内液体的体积缩小时,外界空气将会进入单元,防止接口破损。而且还能节约成本。

不只是设计方面,制造方面也碰到了几项课题。其中之一是冷却板下表面对加工后的尺寸公差要求严格。为了有效完成CPU/ICC与冷却板之间的热交换,冷却板下表面的平面度需要达到数十μm。冷却板的下表面是隔着导热片与CPU/ICC的上表面接触,如果表面凹凸不平,面内的导热率就会出现不均。从而使CPU/ICC与冷却板之间的导热率变差。

单纯通过加工提升金属块的平面度并不困难。然而,冷却板除了微通道的微细加工之外,还需要钎焊外壳和配管的作业。为了不影响平面度,“明确加热条件颇费了一番周折”(富士通企业服务器事业本部安装技术开发统括部久保秀雄)。

开发专用夹具

而且,完成的冷却单元在系统板上安装时也曾接连碰壁。冷却板是隔着弹簧用螺丝固定在CPU/ICC上,但除了固定的螺孔之外,冷却单元上还有一个椭圆孔。其作用是在系统板上安装冷却单元时固定夹具。

在完成冷却单元设计之初,当在系统板上安装冷却单元时,开发人员发现,冷却板很难准确在CPU和ICC上方定位。由于配管具有柔软性,冷却板可以自由活动的范围相当大。

因此,实际组装采用了新开发的专用夹具。下面就来详细介绍一下冷却单元的安装过程。

冷却单元在交付时是用螺丝固定在金属底座上(图3)。使用装卸夹具夹紧冷却板,然后从底座上取下冷却单元进行翻转。其目的是完全清除附着在冷却单元下表面的少量异物。

在完成冷却单元方面的准备后,下面要做的系统板方面的准备(图4)。在CPU/ICC的上表面涂抹酒精,固定导热片。然后,使用夹具在系统板上确定冷却单元的位置,在将冷却板固定到系统板上并取下夹具后,安装即告结束。

机架配管精度要求严格

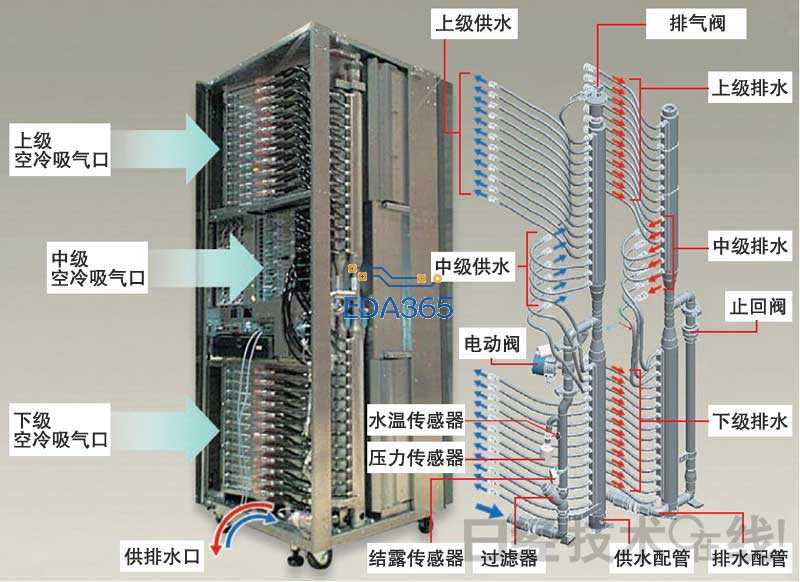

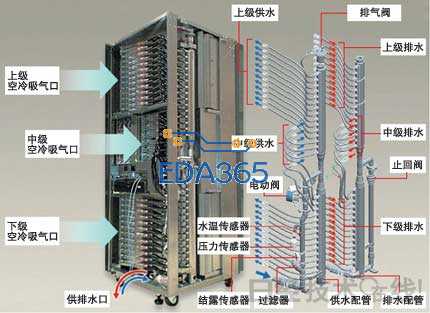

前面介绍了冷却单元开发中设计、制造方面采取的措施,机架内向各个冷却单元供应冷却水的配管的路径设计也绝非等闲(图5)。1个机架最多配备着24枚系统板,而机架的配管连接着这些系统板。

图5:机架与配管布局

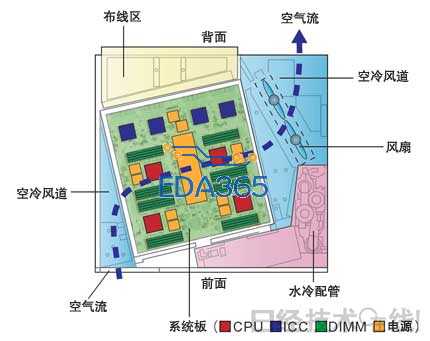

机架右前方为配管空间。连接各系统板的配管分成供水系统和排水系统,有一根纵长的主配管,从中央向外部分岔。 从容纳京的建筑的空间考虑,要想放开必需数量的机架,机架体积就不能过大。必须在有限的空间中为系统板、空冷所需的空气通道和布线留出空间(图6、7)。为了能够取出系统板,前表面也需要开放。

图6:机架截面

考虑到维护性,为了确保空气通道和配管空间,系统板斜放。

图7:系统板的空冷系统

冷却风从系统板的左侧流入,沿存储模块(DIMM)的排列方向送风,从右侧流出。

作为权衡之计,最终采用的方式是系统板相对于机架斜向配置,在右前方区域容纳水冷配管。但如图5所示,从供水和排水两大系统向24枚系统板分岔的配管形状相当复杂。

如上所述,为了均衡各系统板的流量,配管还实施了从主配管中央部分分岔、在途中改变配管粗细等改进。而且,各部分必须配置传感器。

因此,机架内的水冷配管需要高精度加工。通常,这种配管对于精度要求不高,一般是在现场进行调整,而对于京的配管,这种方式完全行不通。设计、生产的两方面都超越了以往的常识。

在开发京的水冷系统时,过去的技术累积发挥了巨大的作用。然而,实际的开发还必须依靠无法一一表达的众多技术经验。此次开发,富士通积累了更为丰富的技术经验。

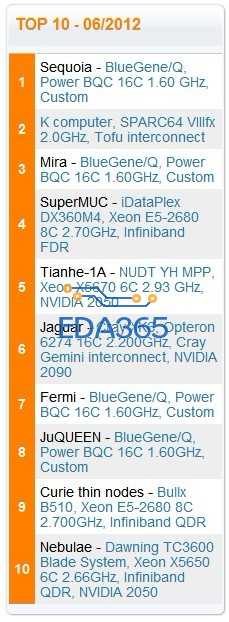

For the first time since November 2009, a United States supercomputer sits atop the TOP500 list of the world’s top supercomputers. Named Sequoia, the IBM BlueGene/Q system installed at the Department of Energy’s Lawrence Livermore National Laboratory achieved an impressive 16.32 petaflop/s on the Linpack benchmark using 1,572,864 cores.

Sequoia is also one of the most energy efficient systems on the list, which will be released Monday, June 18, at the 2012 International Supercomputing Conference in Hamburg, Germany. This will mark the 39th edition of the list, which is compiled twice each year.

Complete information on the trends indicated by the latest list, as well as the complete list, can be found on the TOP500 website.

On the latest list, Fujitsu’s “K Computer” installed at the RIKEN Advanced Institute for Computational Science (AICS) in Kobe, Japan, is now the No. 2 system with 10.51 Pflop/s on the Linpack benchmark using 705,024 SPARC64 processing cores. The K Computer held the No. 1 spot on the previous two lists.

The new Mira supercomputer, an IBM BlueGene/Q system at Argonne National Laboratory in Illinois, debuted at No. 3, with 8.15 petaflop/s on the Linpack benchmark using 786,432 cores. The other U.S. system in the Top 10 is the upgraded Jaguar at Oak Ridge National Laboratory in Tennessee, which was the top U.S. system on the previous list and now clocks in at No. 6.

The newest list also marks a return of European systems in force. The most powerful system in Europe and No.4 on the List is SuperMUC, an IBM iDataplex system installed at Leibniz Rechenzentrum in Germany. Another German machine, the JuQUEEN BlueGene/Q at Forschungszentrum Juelich, is No. 8.

Italy makes its debut in the Top 10 with an IBM BlueGene/Q system installed at CINECA. The system is at No. 7 on the list with 1.72 Pflop/s performance. In all, four of the top 10 supercomputers are IBM BlueGene/Q systems. France occupies the No. 9 spot with a homegrown Bull supercomputer.

China, which briefly took the No. 1 and No.3 spots in November 2010, has two systems in the Top 10, with Tianhe-1Aat the National Supercomputing Center in Tianjin in No. 5 and Nebulae at the National Supercomputing Centre in Shenzhen No. 10.

Total performance of all the systems on the list has increased considerably since November 2011, reaching 123.4 Pflop/s. The combined performance of the last list was 74.2 Pflop/s. In all, 20 of the supercomputers on the newest list reached performance levels of 1 Pflop/s or more. The No. 500 machine on the list notched a performance level of 60.8 teraflop/s, which was enough to reach No. 332 just seven months ago.

A look at processors

A total of 372 systems (74.4 percent) are now using Intel processors, down from 384 systems (76.8 percent) on the last list. Intel is now followed by the AMD Opteron family with 63 systems (12.6 percent), same as in the in the previous list. The share of IBM Power processors has increased from 49 to 58 systems (11.6 percent).

58 systems use accelerators or co-processors (up from 39 six months ago), 53 of these use NVIDIA chips, two use Cell processors, two use ATI Radeon and there is one new system with Intel MIC technology.

The top vendors

IBM kept its lead in systems and has now 213 systems (42.6 percent) compared to HP with 138 systems (27.6 percent). HP is slightly down from 141 systems (28.2 percent) seven months ago, compared to IBM with 223 systems (44.6 percent). In the system category, Cray, Appro, SGI and Bull follow with 5.4 percent, 3.6 percent, 3.2 percent, and 3.2 percent respectively.

IBM remains the clear leader in the TOP500 list in performance and considerably increased its share with 47.5 percent of installed total performance (up from 27.3 percent). HP is second with 10.2 percent down from 13.1 percent. Due to the impressive performance of the No. 1 K Computer, Fujitsu follows closely in the third spot with 9.9 percent, down from 14.7 percent. Cray follows in fourth place in this category with 8.9 percent, down from 14.3 percent.

Where are they now?

The U.S. is clearly the leading consumer of HPC systems with 253 of the 500 systems (down from 263). The European share (107 systems – up from 103) is still lower than the Asian share (121 systems – up from 118). Dominant countries in Asia are China with 68 systems (down from 74), Japan with 34 systems (up from 30). In Europe, UK, France, and Germany, are almost equal with 25, 22, and 20 respectively.

把水换成氟利昂,外面接个压缩机,效果估计会更好!

散热是瓶颈

SuperMUC水冷技术

主板水冷技术设计图

相比于其他超级计算机,SuperMUC的特别之处还在于其水冷技术,传统的超级计算机采用都是空气制冷。根据之前IBM说法,通过水冷技术,SuperMUC能够节能40%以上。

IBM水冷技术

SuperMUC采用的水冷技术是和IBM x iDataPlex一样的技术,确切的说其实是温水制冷技术,因为采用的40摄氏度的入水,而一般情况下,数据中心水冷都是采用16摄氏度的入水。

之所以采用温水,原因在于水的二次利用,常见的数据中心水冷技术中,16度的水经过数据中心的服务器后,排出的水的温度在20度左右,这些水由于温度太低而不能在做其它用途,而IBM采用的温水制冷技术,经过系统后排出的水能够达到70多度。这些水能够二次利用,例如为建筑物供暖等。

Energy Efficiency

SuperMUC uses a new, revolutionary form of warm water cooling developed by IBM. Active components like processors and memory are directly cooled with water that can have an inlet temperature of up to 40 degrees Celsius. The "High Temperature Liquid Cooling" together with very innovative system software promises to cut the energy consumption of the system. In addition, all LRZ buildings will be heated re-using this energy.

Why "warm" water cooling?

Typically water used in data centers has an inlet temperature of approx 16 degrees Celsius and, after leaving the system, an outlet temperature of approx. 20 degrees Celsius. To make water with 16 degrees Celsius requires complex and energy-hungry cooling equipment. At the same time there is hardly any use for the warmed-up water as it is too cold to be uses in any technical processes.

SuperMUC allows an increased inlet temperature. It is easily possible to provide water having up to 40 degrees Celsius using simple "free-cooling" equipment as outside temperatures in Germany hardly ever exceed 35 degrees Celsius. At the same time the outlet water can be made quite hot (up to 70 degrees Celsius) and re-used in other technical processes - for example to heat buildings or in other technical processes.

By reducing the number of cooling components and using free cooling LRZ expects to save several millions of Euros in cooling costs over the 5-year lifetime of the system.

Figure: SuperMUC in the computer room

日本筑波大学一个研究小组9日宣布,他们利用日本最强的超级计算机“京”,成功模拟演算了约2万亿个暗物质粒子在初期宇宙空间的运动情形。

模拟演算显示了约2万亿个粒子由于相互作用的重力而集中,产生了构造物的过程,这将有助于弄清暗物质的性质和宇宙是如何诞生的。

暗物质是宇宙中看不见的物质,也就是说它们没有发出可见光和其他电磁波,因而用天文望远镜看不到它们。但暗物质能够产生万有引力,对可见的物质产生作用。根据现有的假说和观察,科学家估计暗物质占宇宙所有物质总量的90%以上。