华为移动AI芯片麒麟970的GPU技术创新

今日,Arm生态系统合作伙伴华为于北京召开发布会,正式在国内发布搭载10nm工艺制程的年度旗舰处理器麒麟970,同时也是全球首款内置神经元网络单元(NPU)的智能芯片。

在核心配置方面,麒麟970采用了4*Cortex-A73+4*Cortex-A53的大小核设计,其中A73大核主频为2.4GHz,A53小核主频为1.8GHz。在GPU上,麒麟970为Mali-G72 MP12,在视频方面首次支持HDR10,支持4K@60fps视频解码。相机双ISP,支持人工智能场景识别、人脸追焦、智能运动场景检测,夜拍效果得到加强。

作为Arm今年新发的高端GPU,Mali-G72已"装机"麒麟970,它有哪些强大之处?它又是如何对人工智能与机器学习算法进行支持的呢?

机器学习与GPU技术的完美Match人工智能的最近一次浪潮起源于 2011 年前后深度学习(Deep Learning)引起的大发展。在其背后,快速发展的 GPU 功不可没。机器学习作为人工智能领域的一个小分支,如今已是移动计算的关键应用场景之一。通常而言,机器学习在云端上进行,运用训练神经网络的大量数据集实现智能连接,但越来越多的数据也需要在设备端进行,比如像翻译这样的简单任务,通过云端持续传送大量数据,不但增加成本,而且速度也很慢,这也是为何业界开始研究"将机器学习界面放到设备本身"的原因。

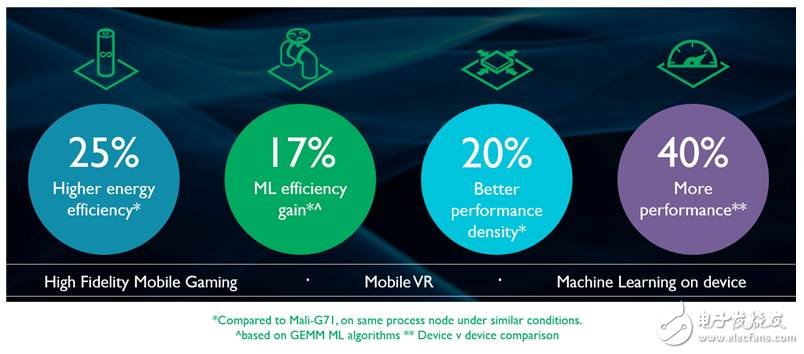

搭载了Mali-G71的华为Mate 9便是一次不错的尝试,它其中的机器学习算法会找出你最常用的应用程序,并对其能耗性能进行优先设置,保证实现最优性能,其中,基于Bifrost架构的Mali-G71功不可没,而Mali-G72性能则更优。相比Mali-G71,Mali-G72性能提升了40%、能效提升25%、每平方毫米的芯片面积效能提升20%,并针对机器学习进行了优化,为机器学习效率带来17%的提升,从而使得Arm能够在整个SoC上更高效地现实分布式智能。期待搭载Mali-G72的新机华为Mate 10的上市。

为何Mali-G72这么牛?除了继续保持Bifrost架构最主要的高效能特色外,像是CPU与GPU彼此间完整的系统一致性、索引式定位着色器等,Mali-G72同时还有多项新武器。Arm增加了区块缓冲存储器(tile buffer memory),以便让GPU在每个运行区块(tile)支持更多的储存空间,也重新平衡了执行引擎的数据路径,移除某些鲜少使用的指令,并以更简单的指令顺序取而代之。同时,Arm针对更多复杂运算进行了优化,为了进一步降低带宽,增加了一级缓存与写回缓存的大小,同时也改变指令缓存逻辑,以便在不增加整体面积与耗电情况下进行更佳利用,并减少对复杂内容产生的缓存遗漏情况。综上,Mali-G72算法优化及增加的高速缓存已经非常成熟,借由此大幅降低带宽,可以实现机器学习最大的效率与效能。

2007年Arm推出基于Utgard架构的Mali-200,当时面向的设备分辨率较低,内容比较简单。Utgard架构的特点是并非像现代GPU设计那样采用了统一渲染引擎,它依旧是一个典型的顶点和像素分离式渲染的产物。

2010年末,Arm推出基于Midgard架构构建的首款GPU Mali-T604,面向的设备可达1080p HD的分辨率,内容变得越来越复杂了。从架构上来看,Midgard是之前Utgard的继承者,但是统一渲染架构和分离式渲染架构的差异如此之大,使得这两个架构又不能直接比较。当然,Midgard还是继承了不少Utgard中优秀的部分,尤其是部分周围功能模块。

2016年,随着内容变得越来越精细,越来越复杂,在GPU渲染的角度来说会有更复杂光影的处理,包括全局光照的处理。从显示面板的角度来看,未来4K的面板也会大量涌现。为满足这样的市场需求,Arm推出了基于崭新GPU架构Bifrost的产品。虽然Bifrost架构看上去与Midgard类似,但其内部的功能模块均有显著的提升,基于前面提到的各种各样的应用场景,包括设备的需求,以及面对的挑战,Bifrost架构都可以解决这样的问题。

- 【科普】手机NFC功能可以做什么?(10-04)

- Xilinx 助力华为加速云服务器(08-19)

- 大联大友尚集团推出基于Fairchild器件的LED照明电源解决方案(11-19)

- AI/机器学习/深度学习三者的区别是什么?(09-10)

- 阿里AI LABS与庆科信息联合推出儿童语音智能解决方案(04-05)

- 盘点人工智能技术的应用领域(05-01)