科普:深度学习真的那么难吗?

时间:04-24

来源:搜狐

点击:

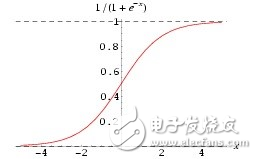

gmoid,也可以用Relu等。激活函数的求导其实也非常简单:

求导: f‘(x)=f(x)*[1-f(x)]

这个方面,有时间可以翻看一下高数,如果没时间,直接记住就行了。至于Relu,那就更简单了,就是f(x) 当x《0的时候y等于0,其他时候,y等于x。当然,你也可以定义你自己的Relu函数,比如x大于等于0的时候,y等于0.01x,也可以。

另一个是学习系数,为什么叫学习系数?刚才我们上面讲到?增量,到底每次增加多少合适?是不是等同于偏导数(变化率)?经验告诉我们,需要乘以一个百分比,这个就是学习系数,而且,随着训练的深入,这个系数是可以变的。

当然,还有一些很重要的基本知识,比如SGD(随机梯度下降),mini batch 和 epoch(用于训练集的选择),限于篇幅,以后再侃吧。其实参考李宏毅的那篇文章就可以了。其实上面描述的,主要是关于怎么调整参数,属于初级阶段。上面其实也提到,在调参之前,都有默认的网络模型和参数,如何定义最初始的模型和参数?就需要进一步深入了解。不过对于一般做工程而言,只需要在默认的网络上调参就可以,相当于用算法;对于学者和科学家而言,他们会发明算法,这有很大的难度。向他们致敬!

- 机器学习算法盘点:人工神经网络、深度学习(07-02)

- 2016年人工智能与深度学习领域的十大收购(07-26)

- AI/机器学习/深度学习三者的区别是什么?(09-10)

- 深度学习的硬件架构解析(10-18)

- 麻省理工科技评论评选的14大医疗领域突破科技(上)(10-14)

- 探秘机器人是如何进行深度学习的(09-18)