人工智能入门基础

不是我们想要 的。

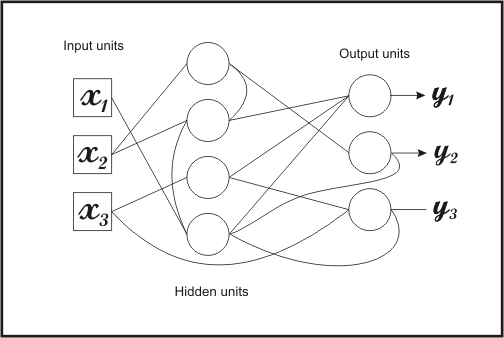

如今,深度学习为我们带来了更多的隐藏层,这是我们如今获得了更好的ANN的原因之一,因为我们需要数百个节点和至少几十个层级,这带来了亟需实时追踪的大 量变量。并行程序的进步也使我们能够运行更大的ANN批量计算。我们的人工神经网络正变得如此之大,使我们不能再在整个网络中同时运行一次迭代。我们需要 对整个网络中的子集合进行批量计算,只有完成了一次迭代,才可以应用反向传播。

有几种类型?

在今天所使用的深度学习中,人工神经网络有很多种不同的结构。典型的ANN中,每个神经元都与下一层的每个神经元相连接。这叫做前馈人工神经网络(尽管如 此,ANN通常来说都是前馈的)。我们已经知道,通过将神经元与其他神经元按特定模式相连接,在处理一些特定情景的问题时,我们就会得出更好的结论。

1、递归神经网络

递归神经网络(RNN)的设计初衷是为了解决神经网络不能基于过去知识做出决策的缺陷。典型的ANN已经在训练中学会了基于文本做出决策,但是一旦它开始为实用做决策,这些决定之间就是彼此独立的。

一个递归神经网络

为什么我们会想要这样的东西?好吧,想一想玩21点游戏。如果一开始你得到4和5,你就会知道2以下的牌都不在牌堆中。这种信息会帮助你决定是否要拿牌。 RNN在自然语言处理中十分有用,因为前文的字词有助于理解文中其他词语的含义。虽然有不同类型的实现方式,但是目的都是一样的。我们想要保留信息。为了 达到这一目的,我们可以通过双向递归神经网络( bi-directional RNN)或执行一个能根据每次前馈来进行调整的递归隐藏层。如果你想学习更多有关RNN的知识,可以查阅这篇博 客:http://karpathy.github.io/2015/05/21/rnn-effectiveness/。

说到这里,就不得不提到记忆网络( Memory Networks),这一概念是说,如果我们想要理解诸如电影或者书中那些构筑于彼此之上的事件时,就必须记住比一个RNN或LSTM(长短期记忆人工神经网络,一种时间递归神经网络)更多的信息。

Sam走进厨房。

Sam拿起苹果。

Sam走进卧室。

苹果掉到了地上。

问:苹果在哪儿?

答:卧室里。

这是这篇论文(http://arxiv.org/pdf/1503.08895v5.pdf)中的例子。

2、卷积神经网络

卷积神经网络(CNN)有时被称为LeNets(以Yann LeCun命名),是层间随机相连的人工神经网络。然而,以这样的方式设置突触是为了有助于减少需要优化的参数量。通过标记神经元连接的某种对称性,你能 「重新使用」神经元以得到完全相同的副本,而不需要同等数量的突触。由于CNN能识别出周围像素的模式,因此它通常用于图像处理。当你将某一像素与其周围 的像素进行比较时,会包含冗余信息。由于存在对称性,你可以压缩类似信息。这听起来像是CNN的完美情况,Christopher Olah也有一篇关于理解 CNNs和其他类型的ANNs的优质博客(http://colah.github.io/posts/2014-07-Conv-Nets- Modular/ )。还有一篇关于CNN的博客:http://www.wildml.com/2015/11/understanding- convolutional-neural-networks-for-nlp/ 。

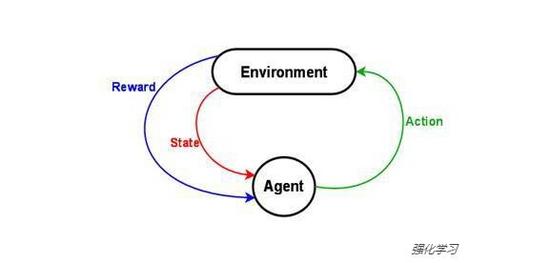

3、强化学习

我想要探讨的最后一种 ANN的类型是强化学习(Reinforcement Learning)。强化学习是一个专业术语,用来描述计算机在尝试将某种回报最大化时所表现出来的行为,这意味着它本身不是一个人工神经网络的结构。然 而,你能用强化学习或遗传算法来构建你以前从没想过要用的人工神经网络结构。 YouTube用户SethBling上传的用强化学习系统来构建可以自己玩Mario游戏的人工神经网络的视频就是个很好的例子。

另一个强化学习的例子是DeepMind公司的视频中展示的能教程序玩各种Atari游戏。

结论

现在,你应该对目前最先进的人工智能有了一定的了解。神经网络正在驱动你能想到的几乎所有事情,包括语言翻译、动物识别、图片捕捉、文本摘要等等。在未来,你将越来越多地听到它的名字。

人工智能 相关文章:

- 解密英伟达Tesla P100、GP100、DRIVE PX2平台(04-26)

- 人工智能处理器三强Intel/NVIDIA/AMD谁称霸?(07-23)

- 2016年人工智能与深度学习领域的十大收购(07-26)

- 人工智能实现的流派 FPGA vs. ASIC看好谁?(08-27)

- IBM沃森能否在人工智能领域突破重围?(09-19)

- 英特尔与高通将在汽车芯片市场再次对决(上)(10-03)