大型IC设计中心的IT环境

如果大家看得上,我就继续,没人看就放弃。

从2004年开始,我写过几次小型IC设计中心的IT环境。比较多的论述了创业类型的芯片设计公司,应该怎么去设计自己的IT环境。这10多年间,有不少初创型的公司来咨询过如何更好的规划IT系统,我都尽力协助解决。

我本人也在这期间经历过各种类型的公司,包括提供EDA平台的苏州ICC,做交换机芯片的CentecNetworks,已经被收购的Broadcom,做嵌入式cpu的China-Core,以及过去两年为其工作的初创大型CPU设计公司,IBM Power8在中国的落地项目中晟宏芯。以上工作经历,给了我很多锻炼,让我在面对各种大小类型的IC设计公司的时候,变得更加成熟。但是,在这个过程中,深感国内的IC设计公司在IT环境的建设方面,跟国际大公司比较,差距依然非常大。

如何将自己的经验分享出来,以提高中国IC设计公司的IT水平,变得越来越重要,也越来越紧迫。希望本文有助于目前在中国逐渐兴起的IC设计行业,在国家的大基金项目下,少走弯路,缩小跟国外的大公司之间的差距。

全文分为11个章节论述:

1.

基础设施建设(机房,弱电间,接入机房,实验室机房及实验室)

2.

网络结构

3.

系统及存储布局

4.

接入及登陆环境

5.

设计Job的管理

6.

数据管理

7.

版本管理

8.

邮件系统

9.

EDA软件管理

10.

多site协同

11.

安全

1. 供电

2. 制冷

3. 布线(水、电、弱电)

4. 环控

5. 空间及位置考虑

6. 交换机布局,ipmi 布局

7. 消防

基础设施主要包含网络、机房等方面,我这里主要介绍的是机房的建设。过去十多年,我建过几台服务器的小机房,也建过几百台服务器的小型数据中心。考量的东西很多,因为本篇主要论述大型IC设计中心的IT环境,所以主要讲的是几百台服务器的机房。

首先,我们来看一张机房的示意图:

我们可以看到这个数据中心分成了多个部分:接入机房,实验室机房,消防钢瓶间,UPS配电间,电池间,主机房,值班室。

建设机房的首要任务是计算出你到底需要多少功率的负荷,然后对接入电源

跟供电方核对,是否有满足需求的电力接入。然后可以确定UPS容量,最后通过设备的断电后备时间要求,计算出需要多少电池。供电系统是一个很复杂的设计,需要机房设计方认真核对,一旦错误,后期很难补救。

作为用户方:我们提供的信息主要有:总机房设备的最大负载、供电冗余要求、每机柜多少KW、电池的后备时间。

目前机房空调主要有两种类型:一种是大型的精密空调,通过上送风或者下

送风的方式,经过机房地板形成一个冷热回路。这种方式在很多地方使用,优点是送风集中,运维方便。缺点就是噪音大,空调冷热路径长,能耗损失多。另外一种,就是行间空调。行间空调顾名思义,就是空调就位于机柜旁边,空调出来的冷风就被机柜上放置的服务器吸入,然后从服务器后端排出热空调,形成循环。

水冷还是风冷?

这也是一个难以取舍的选择。整体来说,风冷技术成熟,能耗比水冷高。但是水冷风险高,因为管路的安装和维护要求高,一旦漏水,对机房来说都是大事故。但是,水冷真的可以很大程度降低能耗。

基于自己的条件,我们选择了行间空调风冷方式。

机房布线的考虑,经常受到环境的限制,经常我们不得不取舍。主要需要考虑的是水管如何布置,包括加湿器的进水管和冷凝水的排水管。强电线缆如何布局以及弱电(双绞线及光纤线缆)布局。

水管的布局,需要考虑漏水的情况下,对机房的影响。机房漏水从来不是小问题,任何处置不当,就可能导致机房停止运行。主要有两方面的水路需要处理,一边为冷凝水的排出,另外就是加湿器的进水。建设机房的时候,建设方提出想把顶楼的排水管在中间开口,通过这个排水口去释放空调的冷凝水,听起来不错吧?可如果大雨的情况下,排水管堵塞或者来不及排出去的时候,水就会从排水管的开口处,直接往机房排放。加湿器进水一定要前置阀门,随时将其管理。否则,自来水的突然高压,可能会导致机房大面积过水。由于进水管的安装问题,我甚至不得不将加湿器进水管完全关闭,以免发生意外。水管一般都是从机房地板下走。

强电的安装需要注意跟弱电分开,因为强电会干扰弱电信号。这就提出了一个现实的问题:强电到底应该走顶部还是地下?因为顶部往往会走弱电线缆。弱电走顶部的一个好处是后期维护和排错更加方便。我这里设计方选择了走地下,地板下有40cm,强电在架设的桥架上走。但是,因为排水管需要有一定高度,不得不走了强电桥架的上部,这应该是一个失败的设计。但是,如果强电走顶部,弱电怎么办?两者之间需要隔离。整体的通道和机柜设计已经解决这个问题,所以建议选择冷通道和机柜的时候,选择好顶部可以分割强弱电布线的产品。这样可以很好的解决强弱电分离的问题,同时避免了强电跟水路一起走的尴尬。

机房环控需要做到几个方面:视频监控,温湿度,漏水检测,电话报警,PUE

的实时显示。

为什么要将接入机房单独出来

接入机房负责跟外界的沟通,包括各家运营商的接入线路:电信的互联网,电信的电话,联通的互联网,专线等。

这个地方经常要开放给电信联通的维护人员,办公网络的核心设备也需要放在这里。外网防火墙,门禁系统,OA服务器等都需要,类似一般公司的小机房。各办公楼层的汇聚。这个机房设计,一般可以考虑单独的UPS,空调。

为什么要建一个单独的实验室机房?

我们都知道,IC设计公司是要做出硬件产品的,而很多工作需要的服务器,不是IT人员去管理,而是设计人员自己做各种测试使用。如果没有一个独立的空间,是无法做好隔离的。这样测试环境会让整个IT系统不稳定。仿真器等设备需要大功率的制冷和独立空间,所以实验室机房采取传统的精密空调,采用下送风的方式制冷。

主机房

我们主机房按照标准模式,设计了独立的消防管网系统,气体灭火。UPS配电间跟电池间。UPS设备目前有模块化的,可以考虑,避免机房设备不足的时候,UPS浪费电力严重的情况发生。

机房的位置选择

这个涉及的考量很多,很多时候我们不得不折中考量,这让人感觉很无奈。比如,我们需要考虑楼层的承重,一旦我们考虑建设机房的地方,如果楼下是空的,就需要建筑设计单位拿出承重设计数据,不能满足我们需求的情况下,我们需要加固。一般情况下,都是不能满足的,没有哪家建筑设计院会将普通的办公楼设计为承重达到机房的要求,除非是厂房设计。一般建筑的承重为250kg—500kg,而我们机房一般要求1000kg-2000kg之间。特别是UPS电池间,这个地方要求的承重非常高。

如果我们选择地下没有架空的一楼做机房,当然就不需要重新加固建筑承重了,但是一楼往往会面临另外一个问题。机房空调的外机往哪儿放?现在的建筑一般都是空调放在顶楼,如果一楼的机房到顶楼的距离过长,会影响制冷效果,能耗也会损失更多。另外,一楼还需要防水,特别是暴雨来临,如果地势低洼,很可能导致倒灌,一旦进入机房,整个机房就可能完全停止工作。

所以,机房的位置选择起来非常难。建议一定要提前选择好地方,且不可将就。

机房网络设备主要是交换机,目前主要采用的有集中式布局和分布式布局。

两种各有优缺点。

集中式布局,一般在一个冷通道采用一台大型多插槽的交换机,这样的布局方式,机房布线是一个难点,因为几百根网线要布局到核心交换机处,线缆的连接非常麻烦,好处是解决问题的时候简单,且由于交换机多采用了个冗余部件,很少出现故障。各个机柜之间也基本是线速连接的。

分布式布局,多采用TOR交换机模式,即每个机柜顶部安装一台交换机,然后各交换机通过上联到核心交换机处实现连接。这样的连接方式,交换机数量比较多,可能不得不浪费很多端口,因为我们一个机柜里边很难会完全用完交换机端口(现在一般交换机都是24口-48口)。这种方式的优点是:布线非常简洁,只要每机柜到核心交换机机柜布置2根6芯的光纤+2根六类线即可。

建议新建的机房采用10G TOR交换机+40G上联,这是趋势,服务器之间采用10G连接的成本已经降到足够低了。可以满足一段时间的需求。

无论采用分布式还是集中式,都推荐在每个机柜上放一台简单2层交换机,用于设备的远程管理口,比如服务器的ipmi端口。这样可以不用随时进出机房去开启关闭服务器。

机房的消防,目前主要采取的是七氟丙烷气体消防。主要考虑的是,提前在

消防部门审批方案和报备,必须是当地有资质的建设方。另外,气体释放的方式最好是经过监控室人工确认,否则可能导致机房人员没有按时撤离,窒息而死。

网络结构

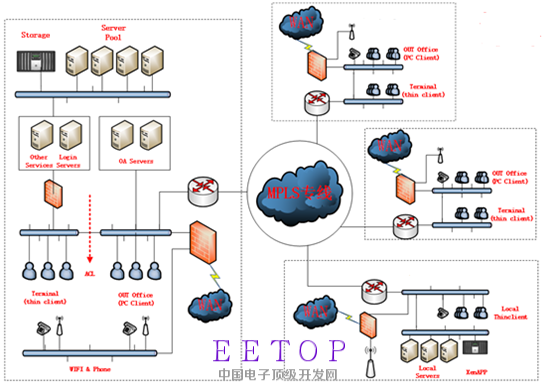

首先让我们来看一个网络的结构示意图,因为这部分涉及到实际内容,我只能通过示意图的方式来简单讲一下基本的要求。无法提供真实的网络结构图给大家看了。

1.

内外网隔离

2.

研发网络跟办公网络隔离

3.

研发网络客户端跟服务器隔离

4.

MPLSVPN网络

我们通过多层防火墙对网络进行了隔离,公司总出口有一个上网的防火墙,

用于隔离互联网跟办公网。我们对外提供的有限服务位于防火墙后面,这也是最容易被外部攻击的区域。在这里,我们通过ACL等措施隔离办公网络流量,防火墙部署入侵检测和杀毒等服务。

研发网络指的是我们设计芯片的网络。这里一般采用两种方式隔离,一种

是物理隔离,另一种是逻辑隔离,各有优缺点,按需采用即可。物理隔离的优点是安全,任何通过网络入侵的机会将为零。但是缺点是实用性和方便性遇到困难,无法做到多个异地site协同工作。逻辑隔离是采用各种安全规范,严格限制研发网络跟办公网络的交互,实现即时办公网络被入侵,依然可以保证研发网络安全的网络设计。这种优点是可以多site协助,跟外部交流容易。缺点就是存在安全错误导致的安全风险存在可能。

研发网络的服务器端一般位于机房内,而客户端位于工位。两者之间如果不

能有效隔离,就会造成安全风险点大面积增加。同时,对内的安全防护就无从谈起。使用,我们一般会在登陆客户端跟设计服务器之间采用防火墙来隔离。同时,登陆服务器也需要采取各种安全措施,避免被内部用户入侵控制。

专线网络有多种,常用的可能有MSTP/SDH

MPLS。SDH专线主要用在国内

点对点电路上,相当于给提供物理链路给你。这种方式优点是点对点,只要电路不断,你的网络一定不会跟其他共享带宽。MPLS VPN是用的更多的专线方式,其特点是环状组网,使用逻辑隔离,将数据从一个大的带宽网络中隔离出来,运营商采用各种方式尽量保证你的带宽符合你申请的带宽。

如果只是两点,可以考虑SDH,如果是多点,建议还是用MPLS VPN比较合适。专线方式可以提供比互联网ipsec vpn更好的稳定性,建议研发的工作环境采用。而对于稳定性要求不高的应用,建议还是采用传统的ipsec vpn方式节省费用,比较专线每月都需要付出一大笔钱。

额外提示一点:目前研发设计网络,经常需要使用google等搜索引擎查询资料。国内的网络连接国外有防火墙封锁,同时两大运营商的问题导致访问国外异常慢,丢包率非常高。解决这类问题,目前有几个办法:方法一,购买一些vpn服务账号,适合个人使用。方法二、公司拉一条专线到香港,通过香港本地上internet。适合公司一起使用的,但是这种方式成本很高,差不多1000元/M,一条10M的线路需要每个月一万了。方法三、通过上面所述的MPLS VPN,路由到国外再上internet,类似方法二,只是成本更高,如果刚好有上下线非对称应用,比如国外分部主要通过MPLS访问总部资源的时候,主要是下行带宽,总部可以利用其上行带宽。方法四、采用SDN的方式和云计算结合,通过公有云实现这类应用,成本在100-300RMB/兆

之间,非常适合小公司。

系统和存储布局

1. CPU架构及OS考虑

2. 认证(NIS AD LDAP及其他)

3.DNS/NTP

4.

Email

5. 存储:zfs/netapp

6.

NFS v3/v4 和AFS GPFS之间的优缺点

看过我以前文章的朋友,一定会记得,2004年,我推荐Solaris8。2008年推荐的OS是RHEL3和RHEL4,到了2013年我写的文章,已经推荐RHEL5了。今天(2015年底)我推荐的是RHEL6.7。推荐OS必须跟当时所处的情况有关,目前三大软件商cadence synopsys mentor都已经支持RHEL6,所以采用RHEL6毫无问题。我们目前全部都采用的是RHEL6.7的OS。

CPU架构方面,依然推荐Intel的E5-2600v3和v4双路服务器,特殊情况可以考虑E7的4路服务器。作为一家主要引入IBM Power8处理器设计的公司来说,采用intel的CPU是不是有些特别的意味?一点也不奇怪,因为EDA vendor的主要软件都是支持x86的处理器,只有少量软件会支持AIX+Power。而从性价比来说,显然x86更有优势。

OS安装需要采用kickstart实现一致性安装,即所有服务器跑的系统和软件包都一样。实现本地的OS image和epel库,然后通过pssh等分布式管理工具实现软件安装的一致性要求。

用户认证,必须实现统一账号,在任何系统下,最好是同一个账号和密码。

目前能够实现这个条件,需要windows的Active Directory和NIS或者LDAP统一。

我这里采用了windows 2008R2 + NIS来实现,使用NIS这么古老的认证技术主要是考虑了其简单方便性,没有过多考虑其他如安全等特性。

Windows 2008R2,集成可SFU的功能,可以为unix用户设置一些特性,比如uid gid shell home,另外,还提供NIS服务器功能,可以实现windows账号和unix账号的统一。

采用NIS的原因是我们会在后面实现autofs功能,这样PXE安装的Linux服务器就不需要挂载很多文件系统,而直接采用autofs的方式挂载。

在未来,Unix下认证应该会跟逐步LDAP集成。

实现内部DNS服务功能可以提供内部服务器之间的便捷访问,从而摆脱记忆

ip地址的麻烦。某些服务器在采用了内部dns后,可以更容易使用。目前提供dns服务器的主要有两个程序:bind和dnsmasq。前者是传统的dns服务器,功能强大。后者是简单的dns+dhcp服务,一般用于小型环境。优点就是便捷,使用方便。具体服务器搭建,这里不再详细介绍,提醒一点是dnsmasq默认不提供跨vlan的dns服务,需要绑定interface。

内部ntp服务在这种环境下几乎是必须的。Ntp可实现内部时间的统一,避免认证失败或者文件时间冲突等问题。Ntp服务器的实现非常简单,不做介绍,注意要周期性跟ntp服务器同步时间。

Email依然是当前企业通信的最主要方式,所以email系统的选择也是一个重

要的工作。由于我们公司采用了内外网隔离的方式,所以我们的平时跟外部联系的邮件系统跟内部邮件系统是完全独立的两套。

外部邮件系统主要考虑的是防病毒,防垃圾邮件,安全,可维护性及尽量少的中断时间。基于以上考虑,我们最终选择了托管出去的方式。以前在多家公司,都用了自己搭建的邮件系统,包括exchange或者其他专业的邮件软件,开放25端口来跟外部通信。其中最麻烦的事情不是安全,而是垃圾邮件太多。如果公司自己购买一台垃圾邮件过滤系统,费用很高且可能一定程度误报误删,这样对公司来说是无法接受的。由于新建公司没有多少邮件迁移的任务,我们最终采用了托管出去的方式,按用户付费,这样完全避免了垃圾邮件的困扰。

内部邮件系统,我们采用了postfix来自己搭建一套。考虑到有需求,我们采取措施,让托管出去的邮件可以直接转发到内部邮件服务器上。这里涉及到了一个中转服务器。

存储系统的选择非常重要,几乎决定了后期整个系统性能的关键因素。在IC

设计行业中,有几个重要因素需要考虑:实时压缩、高速SSD做缓存、重复数据删除、snapshot、NFS v4 ACL、Backup。

对于以上特点,我这里简要介绍需要的原因:

实时压缩,可以很大程度减少存储容量的使用。在IC设计中,经常可以做到2倍的压缩率,即容量提升了一倍。同时,还提升了IO能力,因为压缩后的数据更小,有利于读写。现代的CPU都很快,压缩不会带来太大的负担。所以,可以放心使用。

高速SSD缓存,全闪存太贵,而采用SSD做缓存的方案,可以很大程度上将热点数据放在高速SSD上,遇到调用的时候不再去磁盘中寻找,这样可以很大程度上提供IOPS,是一种利用较低成本提供了较大效益的方案。

重复数据删除,重复数据删除功能可以在很大程度上减少磁盘空间的使用量,特别是针对某些应用,比如虚拟化及多版本开发环境。

Snapshot,这里的snapshot一定要跟SAN盘阵的区分开来,也跟LVM的不一样。基于netapp和zfs的snapshot功能,允许用户自我管理不小心删除的数据,随时自己去恢复,减少管理员的麻烦。提高了用户的满意度。

NFSv4 ACL,由于其提供了很多高级特性,可以实现项目的管理方式,让项目经理去管理目录的权限,将IT从权限管理的繁琐中解脱,同时,给项目经理足够大的自由度,让他们更快捷的实现自己的要求。

备份,是一个重要的话题,数据备份可能永远都是在做后备,但是一旦需要恢复,备份就显得格外重要。目前主要考虑采用D2D的备份+磁带归档的方式实现长期的数据备份需求。

由于我们的环境主要是NAS存储的NFS共享,满足以上要求的主要有netapp的存储及基于zfs的存储系统,如oracle ZS4

nexentastor等。

目前在国内做支持最好的依然是netapp存储,但是netapp的销售策略要小心,存在销售控制价格的行为特别严重,甚至可以做到价格差异30%-50%的情况。因为是区域控价,你如果选定了必须用它,几乎无任何的议价能力,被迫接受高价。在大厂商面前,用户很弱势。唯一的反击就是绝对不要选择某一家厂商的产品作为采购要求。

v3/v4 及AFS GPFS文件系统的优缺点

NFS v3是过去和当前依然在大量使用的协议,几乎所有的系统都能支持,使

用和配置也很简单。但是,nfsv3 缺乏一些特性,如安全性不足,缺乏更严格的acl支持,缺乏并行支持等。所以,后来开发了nfs v4,提供了更加先进的一些功能。我们主要会使用到nfs v4的功能就是nfs v4 acl支持。目前很多测试环境下,nfs v3的性能依然比nfs v4更快。所以,除了需要设置acl的时候,否则其他地方应该挂载nfs v3为主。

AFS文件系统是另外一种主要的网络文件系统,其提供了很多优秀的功能,比如本地cache,acl,quota,分布式等。但是,国内很少用到,商业化支持也不足,所以不建议使用。

GPFS是IBM开发的商业产品,可以实现分布式,如果不考虑费用问题,可以考虑在某些关键的应用中采用。

预留13

前面发了预留位,结果需要审核。那么,我从这里开始正式写吧,等全部发完,再复制到前面预留位,方便阅读。

基础设施建设

1. 供电

2. 制冷

3. 布线(水、电、弱电)

4. 环控

5. 空间及位置考虑

6. 交换机布局,ipmi 布局

7. 消防

基础设施主要包含网络、机房等方面,我这里主要介绍的是机房的建设。过去十多年,我建过几台服务器的小机房,也建过几百台服务器的小型数据中心。考量的东西很多,因为本篇主要论述大型IC设计中心的IT环境,所以主要讲的是几百台服务器的机房。

首先,我们来看一张机房的示意图:

我们可以看到这个数据中心分成了多个部分:接入机房,实验室机房,消防钢瓶间,UPS配电间,电池间,主机房,值班室。

建设机房的首要任务是计算出你到底需要多少功率的负荷,然后对接入电源

跟供电方核对,是否有满足需求的电力接入。然后可以确定UPS容量,最后通过设备的断电后备时间要求,计算出需要多少电池。供电系统是一个很复杂的设计,需要机房设计方认真核对,一旦错误,后期很难补救。

作为用户方:我们提供的信息主要有:总机房设备的最大负载、供电冗余要求、每机柜多少KW、电池的后备时间。

目前机房空调主要有两种类型:一种是大型的精密空调,通过上送风或者下

送风的方式,经过机房地板形成一个冷热回路。这种方式在很多地方使用,优点是送风集中,运维方便。缺点就是噪音大,空调冷热路径长,能耗损失多。另外一种,就是行间空调。行间空调顾名思义,就是空调就位于机柜旁边,空调出来的冷风就被机柜上放置的服务器吸入,然后从服务器后端排出热空调,形成循环。

水冷还是风冷?

这也是一个难以取舍的选择。整体来说,风冷技术成熟,能耗比水冷高。但是水冷风险高,因为管路的安装和维护要求高,一旦漏水,对机房来说都是大事故。但是,水冷真的可以很大程度降低能耗。

基于自己的条件,我们选择了行间空调风冷方式。

机房布线的考虑,经常受到环境的限制,经常我们不得不取舍。主要需要考虑的是水管如何布置,包括加湿器的进水管和冷凝水的排水管。强电线缆如何布局以及弱电(双绞线及光纤线缆)布局。

水管的布局,需要考虑漏水的情况下,对机房的影响。机房漏水从来不是小问题,任何处置不当,就可能导致机房停止运行。主要有两方面的水路需要处理,一边为冷凝水的排出,另外就是加湿器的进水。建设机房的时候,建设方提出想把顶楼的排水管在中间开口,通过这个排水口去释放空调的冷凝水,听起来不错吧?可如果大雨的情况下,排水管堵塞或者来不及排出去的时候,水就会从排水管的开口处,直接往机房排放。加湿器进水一定要前置阀门,随时将其管理。否则,自来水的突然高压,可能会导致机房大面积过水。由于进水管的安装问题,我甚至不得不将加湿器进水管完全关闭,以免发生意外。水管一般都是从机房地板下走。

强电的安装需要注意跟弱电分开,因为强电会干扰弱电信号。这就提出了一个现实的问题:强电到底应该走顶部还是地下?因为顶部往往会走弱电线缆。弱电走顶部的一个好处是后期维护和排错更加方便。我这里设计方选择了走地下,地板下有40cm,强电在架设的桥架上走。但是,因为排水管需要有一定高度,不得不走了强电桥架的上部,这应该是一个失败的设计。但是,如果强电走顶部,弱电怎么办?两者之间需要隔离。整体的通道和机柜设计已经解决这个问题,所以建议选择冷通道和机柜的时候,选择好顶部可以分割强弱电布线的产品。这样可以很好的解决强弱电分离的问题,同时避免了强电跟水路一起走的尴尬。

机房环控需要做到几个方面:视频监控,温湿度,漏水检测,电话报警,PUE

的实时显示。

为什么要将接入机房单独出来

接入机房负责跟外界的沟通,包括各家运营商的接入线路:电信的互联网,电信的电话,联通的互联网,专线等。

这个地方经常要开放给电信联通的维护人员,办公网络的核心设备也需要放在这里。外网防火墙,门禁系统,OA服务器等都需要,类似一般公司的小机房。各办公楼层的汇聚。这个机房设计,一般可以考虑单独的UPS,空调。

为什么要建一个单独的实验室机房?

我们都知道,IC设计公司是要做出硬件产品的,而很多工作需要的服务器,不是IT人员去管理,而是设计人员自己做各种测试使用。如果没有一个独立的空间,是无法做好隔离的。这样测试环境会让整个IT系统不稳定。仿真器等设备需要大功率的制冷和独立空间,所以实验室机房采取传统的精密空调,采用下送风的方式制冷。

主机房

我们主机房按照标准模式,设计了独立的消防管网系统,气体灭火。UPS配电间跟电池间。UPS设备目前有模块化的,可以考虑,避免机房设备不足的时候,UPS浪费电力严重的情况发生。

机房的位置选择

这个涉及的考量很多,很多时候我们不得不折中考量,这让人感觉很无奈。比如,我们需要考虑楼层的承重,一旦我们考虑建设机房的地方,如果楼下是空的,就需要建筑设计单位拿出承重设计数据,不能满足我们需求的情况下,我们需要加固。一般情况下,都是不能满足的,没有哪家建筑设计院会将普通的办公楼设计为承重达到机房的要求,除非是厂房设计。一般建筑的承重为250kg—500kg,而我们机房一般要求1000kg-2000kg之间。特别是UPS电池间,这个地方要求的承重非常高。

如果我们选择地下没有架空的一楼做机房,当然就不需要重新加固建筑承重了,但是一楼往往会面临另外一个问题。机房空调的外机往哪儿放?现在的建筑一般都是空调放在顶楼,如果一楼的机房到顶楼的距离过长,会影响制冷效果,能耗也会损失更多。另外,一楼还需要防水,特别是暴雨来临,如果地势低洼,很可能导致倒灌,一旦进入机房,整个机房就可能完全停止工作。

所以,机房的位置选择起来非常难。建议一定要提前选择好地方,且不可将就。

机房网络设备主要是交换机,目前主要采用的有集中式布局和分布式布局。

两种各有优缺点。

集中式布局,一般在一个冷通道采用一台大型多插槽的交换机,这样的布局方式,机房布线是一个难点,因为几百根网线要布局到核心交换机处,线缆的连接非常麻烦,好处是解决问题的时候简单,且由于交换机多采用了个冗余部件,很少出现故障。各个机柜之间也基本是线速连接的。

分布式布局,多采用TOR交换机模式,即每个机柜顶部安装一台交换机,然后各交换机通过上联到核心交换机处实现连接。这样的连接方式,交换机数量比较多,可能不得不浪费很多端口,因为我们一个机柜里边很难会完全用完交换机端口(现在一般交换机都是24口-48口)。这种方式的优点是:布线非常简洁,只要每机柜到核心交换机机柜布置2根6芯的光纤+2根六类线即可。

建议新建的机房采用10G TOR交换机+40G上联,这是趋势,服务器之间采用10G连接的成本已经降到足够低了。可以满足一段时间的需求。

无论采用分布式还是集中式,都推荐在每个机柜上放一台简单2层交换机,用于设备的远程管理口,比如服务器的ipmi端口。这样可以不用随时进出机房去开启关闭服务器。

机房的消防,目前主要采取的是七氟丙烷气体消防。主要考虑的是,提前在

期待学习!

期待学习!

顶,赞,强!